Dass ich KI faszinierend finde, weil sie zu Experimenten einlädt und die Kreativität unterstützt, ist wohl klar. Aber: KI ist eine schwarze Technologie — Zeit für eine konzentrierte Auflistung ihrer Sünden: 10 Gründe, warum man eigentlich keine KI nutzen sollte.

1.:

Der rosa Dinosaurier im Bild ist Teil eines kleinen Experiments, das ich KI-Seminaren durchspiele: Die Teilnehmenden bekommen die Aufgabe, einen länglichen und schier unlesbaren Pressetext auf die entscheidenden Stichpunkte einzudampfen. ChatGPT, Claude oder Mistral erledigen das natürlich im Handumdrehen — aber versäumen zu erwähnen, dass der Text einen sehr merkwürdigen Satz enthält: Er behauptet, einer der Zitatgeber reite auf einem rosa Dinosaurier davon. Der Bruch fällt keiner KI auf; man muss erst gezielt danach fragen.

Natürlich ist das nicht fair. Aber es soll das Bewusstsein dafür wecken, dass wir ganz kurz davor sind, uns von der KI als erstem Informationsfilter abhängig zu machen. Die Versuchung ist groß: Wenn mir NotebookLM einen Überblick einer mehrtausendseitigen Materialsammlung erstellt — warum dann die Originalquellen noch lesen? Der KI- und Internet-Versteher Seth Godin spricht von der „entschuldigenden Arroganz des tl;dr:“ und warnt vor einer „Dopamin-Kultur“, die sich die Mühe des Verstehens nicht mehr machen will – oder kann.

Der im Bild oben zitierte Software-Entwickler (Quelle auf Linkedin) sieht wenig Nutzen in KI-Programmier-Assistenten, aber fürchtet, dass ihre Nutzung wichtige Fähigkeiten verkümmern lässt. Nun ist KI als Coding-Hilfe für schlechte Programmierer wie mich ein Geschenk; aber man muss sehr darum kämpfen, immer auch nachzuvollziehen, was die KI da als Programmcode vorgeschlagen hat. Aus Gründen.

Kleine, böse Fußnote: Eine Harvard-Studie fand unlängst heraus, dass KI-Coding-Assistenten auch erfahrene Programmierer produktiver macht, aber das liegt anscheinend vor allem daran, dass sie weniger Zeit in Abstimmungen mit Kolleginnen und Kollegen verbringen, weil sie die Aufträge lieber gleich an eine KI delegieren. Weniger Kommunikation im Team dank KI; kein sehr positiver Effekt.

2.:

Für generative KI braucht man gewaltige Mengen Energie, deren Herstellung gewaltige Mengen CO2 in die Atmosphäre bläst: Jedes KI-Bild verbraucht in etwa so viel Energie, wie man braucht, um einmal sein Handy voll aufzuladen. Und schon beim Training werden immer größere Energiemengen verbraten; kein Wunder, dass nicht nur Amazon über reaktivierte und neue Atomkraftwerke nachdenkt.

Kleine, böse Fußnote: Im Vergleich mit den anderen Tech-Riesen ist Google vergleichsweise transparent, wenn es um den Energieverbrauch geht, und hat sich ein klares Ziel gesetzt: Die Datencenter sollen in naher Zukunft nur noch mit erneuerbaren Energien betrieben werden. KI hat dieses Ziel in die Ferne rücken lassen, was das obige Video der Tech-Reporter von Proof News sehr verständlich und knapp aufschlüsselt.

3.:

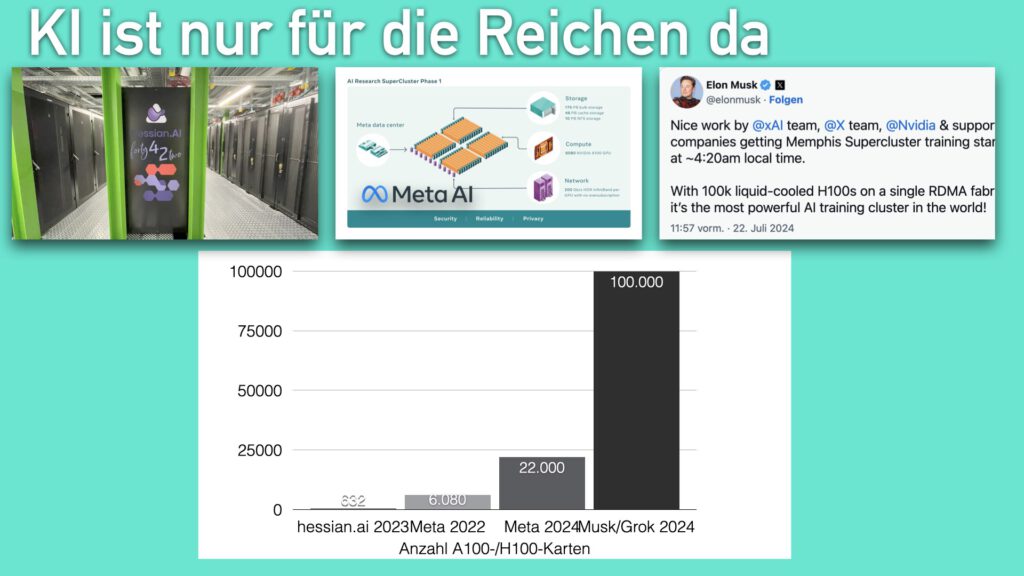

Seit Mitte 2023 gibt es ganz in meiner Nähe einen KI-Superrechner für die Forschung: „Forty-Two“ in Darmstadt ist einer der leistungsstärksten KI-Cluster in Deutschland und soll dazu dienen, neue, für Europa angepasste Modelle zu trainieren. Er verfügte beim Start über 632 A100-Spezialchips von NVIDIA. Das ist eine Menge, weil jeder dieser Chips etwa so viel kostet wie ein Mittelklassewagen; damit sind diese Chips und ihre aktuellen Nachfolger zur Messgröße der KI-Power geworden.

Und die ist sehr ungleich verteilt. Zur gleichen Zeit, als „Forty-Two“ gebaut wurde, trainierte Meta die 2. Generation seiner Llama-Sprachmodelle, auf zwei KI-Clustern mit jeweils etwa 10x soviel Rechnenpower. Für die aktuelle Llama3-Generation hat Meta zwei Rechner mit 22.000 Chips in Betrieb, und Grok, das KI-Projekt von Elon Musk, prahlt mit 100.000 KI-Chips. Die Investitionen sind ein Spiel, dass nur noch ganz wenige mitspielen können. Die staatlich finanzierte Forschung in Europa hat schon lang aufgegeben, dabei mithalten zu wollen.

Jetzt kann man statt ChatGPT und Co. auch eine frei herunterladbare KI wie Llama3.3 nutzen, aber diese Modelle sind von den Launen von Großkonzernen wie Meta abhängig, und von ihrer Bereitschaft, die Ergebnisse von Milliardeninvestitionen zu verschenken, nur um der Konkurrenz das Geschäft zu verderben. Und die Nutzungsbedingungen für diese Modelle können sich schnell ändern: „Open weights are not open source“.

Kleine, böse Fußnote: Die Zeit, in der uns die Tech-Riesen die Rechnung für diese gewaltigen Kosten präsentieren, rückt näher. Gut abzulesen an dem neuen 200-Dollar-Monatsabo von OpenAI, das das bisherige 20-Dollar-Abo zu einer Art besserem Fanclub degradiert. Die Top-KI bleibt der zahlenden First Class vorbehalten; 5 Milliarden Dollar Verlust im Jahr tun selbst auch einer mit Microsoft verpartnerten Firma irgendwann weh.

4.:

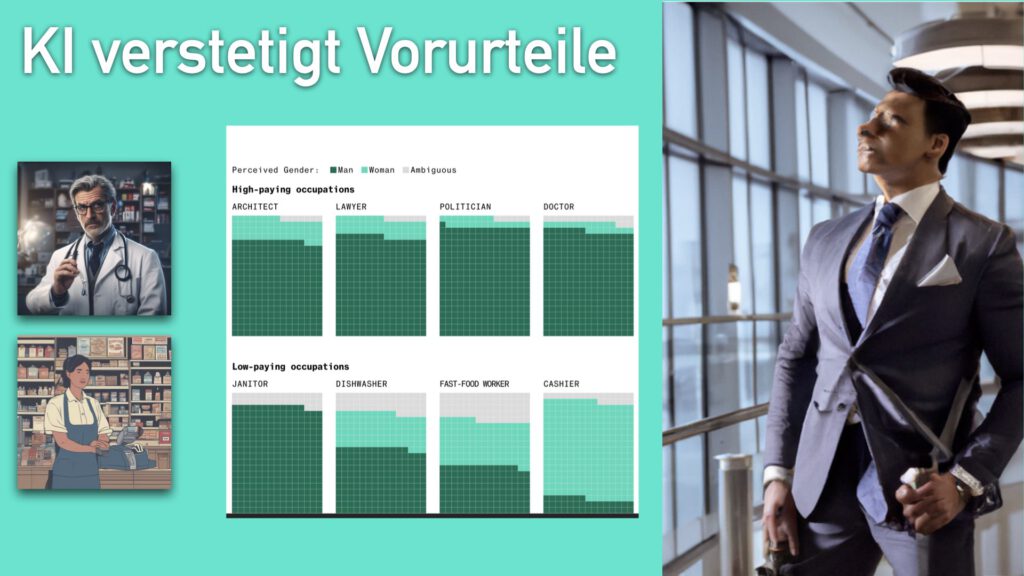

Ein kleines Experiment mit Stable Diffusion oder Flux: Gib 10x einfach das Wort „doctor“ als Bildbeschreibung ein, dann 10x das Wort „cashier“. Es ist recht wahrscheinlich, dass dann so etwas herauskommt wie auf den beiden Bildern oben: Der Arzt ist ein älterer, weißer Mann. Die Kassiererin ist weiblich, jünger und hat Migrationshintergrund. Das ist kein Zufall, sondern eine systematische Verzerrung (Bloomberg): Die KI gibt eine stereotypische Schieflage in den Trainingsdaten wieder.

Das betrifft auch Sprachmodelle: Sie schreiben Vorurteile fort. Wer sich von ChatGPT Figuren erfinden lässt, muss schon einiges an Zeit und Mühe investieren, dass nicht immer Stefan und Katja dabei herauskommen, sondern auch mal Murat und Laila.

Kleine, böse Pointe: Alle Bildgeneratoren haben diese Schieflagen, mehr oder weniger; auch die, die ein Sprachmodell davorschalten, um die Schwächen auszugleichen: Es ist praktisch unmöglich, mit DALL-E ein Bild einer blonden Frau Mitte 50 im Büro zu erzeugen, die nicht wie ein Supermodel aussieht.

5.:

Diesen Gesichtsausdruck hat die damalige Technik-Chefin von OpenAI aufgesetzt, als eine Reporterin sie gefragt hat, ob OpenAI Youtube-Videos als Trainingsmaterial nutzt, ohne zu fragen. Um nochmal die famosen Tech-Rechercheure von Proof News zu bemühen: Ja, tun sie. Auch wenn das möglicherweise nicht mal illegal ist: Die Tech-Konzerne verhalten sich wie jemand, der in den örtlichen Zeitungskiosk geht, alles durchblättert, Notizen und Fotos macht, und dann wieder verschwindet, ohne auch nur ein Magazin zu kaufen.

Youtube-Videos sind auch ein Teil des Geheimnisses der deutlich verbesserten Leistungen von GPT-4ff. gegenüber dem ChatGPT-Einsteigermodell GPT-3.5. Es ist schon kein Zufall, dass OpenAI praktisch gleichzeitig mit ChatGPT auch Whisper veröffentlicht hat, ein Modell zur Verschriftlichung von Audio…

Kleine, böse Pointe: …das unter anderem mit öffentlich-rechtlichen Untertiteln trainiert wurde.

6.:

So hemmungslos die Tech-Riesen sich bei unseren Inhalten bedienen, so wenig bereit sind sie, ihre Trainingsdatenquellen offenzulegen. Und in diesen Quellen verbirgt sich einiges. Elisa Harlan und Katharina Brunner haben das für den BR anhand der Trainingsdaten von Stable Diffusion nachgezeichnet, konnten das aber nur deshalb, weil Stable Diffusion auf dem offenen Trainingsdatensatz von LAION beruhte.

Welche Quellen noch in das Training der Modelle eingeflossen sind? Welche Schieflagen sich noch in den Trainingsdaten verbergen? Wir wissen es nicht — darauf achten Google, OpenAI/Microsoft und Amazon schon.

Kleine, böse Pointe: books3.

7.:

Griff an die eigene Nase: Ich erstelle auch für dieses Blog gern Bilder mit Midjourney und Co., zum einen, weil ich mich immer wieder darüber freue, welche Ideen der generativ aufgearbeitete Zufall sprießen lässt. Zum anderen würde ich solche Bilder nie selbst montieren oder zeichnen können, und da ich für ein privates Blog auch nicht jedes Mal einen Grafiker beauftragen kann, nutze ich die KI-Bilder.

Warum sollten das aber nicht auch diejenigen tun, die das Geld durchaus ausgeben? Die KI-generierten Songs von Suno und Udio sind oft ziemlich cheesy — als Jingles für einen Werbespot sind sie attraktiv genug. KI-Stimmen lassen die Verdienstmöglichkeiten für Sprecherinnen einbrechen. (hessenschau) Und wer schickt noch drei Leute auf einen Video-Dreh, wenn man die gleiche Szene schnell mit Runway erzeugen kann, noch dazu viel besser ausgeleuchtet?

All das zerstört Verdienstmöglichkeiten für die, die Kunst machen, ohne von Kunst leben zu können – fast alle Künstlerinnen und Künstler. Musiker leben von den Film- und Werbeproduktionen. Schauspielerinnen arbeiten als Sprecherin. Und ohne Werbung keine Arbeit für die meisten Regisseure.

Natürlich werden Menschen auch weiter Kunst machen; was bleibt ihnen übrig. Und KI gibt kreativen Menschen wundervolle Möglichkeiten, sich auszudrücken. Aber sie werden immer weiter abhängig von Mäzenen und Sponsoren.

Kleine, böse Pointe: Ein Fan schickt dem Sänger Nick Cave einen Songtext von ChatGPT im Stil von Nick Cave – und Nick Cave antwortet: Ja, das ist ein Text, der so aussieht, als könnte ich ihn geschrieben haben — aber meine Texte entstehen doch nicht, um eine bestimmte Form zu imitieren, sondern weil ich eine menschliche Erfahrung kondensiert und ausgedrückt habe, unter Schmerzen. Cave schließt seine Antwort an den Fan so ab:

Mark, thanks for the song, but with all the love and respect in the world, this song is bullshit, a grotesque mockery of what it is to be human, and, well, I don’t much like it — although, hang on!, rereading it, there is a line in there that speaks to me —

‘I’ve got the fire of hell in my eyes’

— says the song ‘in the style of Nick Cave’, and that’s kind of true. I have got the fire of hell in my eyes – and it’s ChatGPT.

Love, Nick

8.:

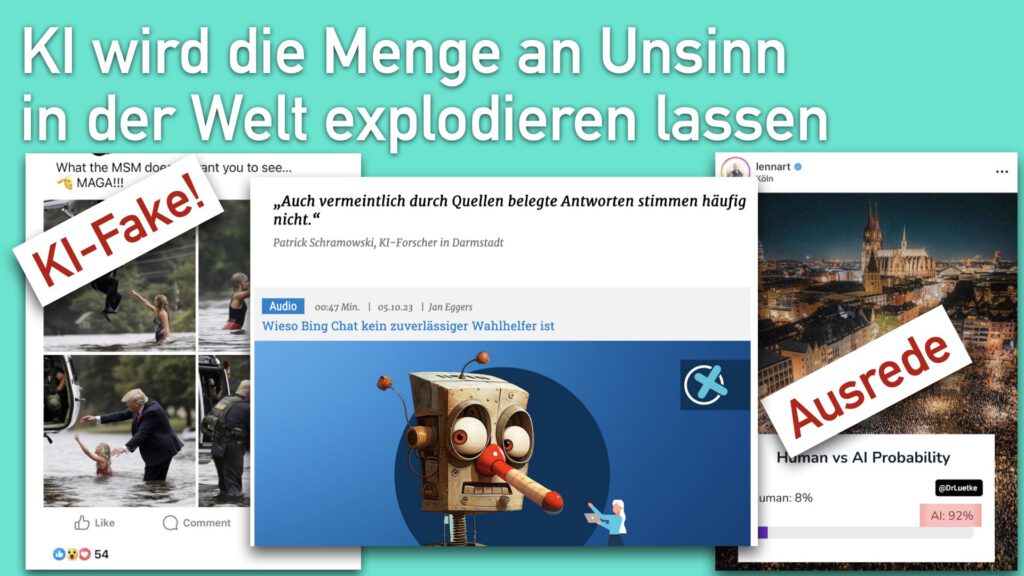

„Slop“, KI-generierter Info-Müll: Im besten Fall sind es leicht zu erkennende Skurrilitäten wie der „Aussiedlerbote“ (tagesschau.de). Deutlich bedenklicher sind Plattformen wie „Meliorator“, ein vergangenen Sommer vom FBI stillgelegtes automatisiertes Troll-Netzwerk; dabei setzte „Meliorator“ noch auf GPT-3, also ein Sprachmodell der vorvorvorletzten Generation. Mit aktuellen Open-Source-Modellen und -Videogeneratoren kommt da auf Tiktok ein ganz anderer Zug rein.

Es ist so viel leichter, mit generativer KI Unsinn zu produzieren als etwas Wahres, und das nicht nur, weil Sprachmodellen die Halluzinationen mit derzeitiger Technologie nie ganz auszutreiben sind. Für jemanden, der bloß möglichst viele Artikel in den Google-Suchindex schießen will, sind Halluzinationen kein Problem, ebensowenig wie für hyperparteiische „News“-Seiten oder russische „Doppelgänger“-Kopien deutscher Nachrichtenportale.

Böse, kleine Pointe: Das Ziel von Desinformation ist ja weniger, eine Lüge zur Wahrheit zu erheben, als die Wahrheit zu entwerten und in einem Meer von alternativen Wahrheits-Entwürfen untergehen zu lassen. „Flooding the zone with shit“, wie der Trump-Berater Steve Bannon das mal genannt hat. Generative KI macht das unendlich viel billiger.

9.:

Wissen, was jemand im Netz sucht, noch bevor er es selber weiß: Der damalige Google-Chef Eric Schmidt hat schon vor 15 Jahren formuliert, wie Google seine Dominanz über den lukrativen Werbemarkt absichern will. Um das zu ermöglichen, muss man aus möglichst vielen Verhaltensdaten möglichst genau Verhaltensweisen ableiten.

Von daher: Glaubt jemand, dass irgendetwas, das wir bei Google hochladen, auch irgendwann mal wieder gelöscht wird?

10.:

Eine Technologie, mit der man menschliches Verhalten imitieren und vorhersagen kann, ist aber auch hervorragend geeignet, um Einfluss auf Menschen auszuüben.

Über die Trollfarmen und Pink-Slime-Produzenten haben wir schon gesprochen. Richtig tiefen Polit-Grusel liefert ein Blick nach Indien: Die zunehmend autoritär auftretende Regierungspartei BJP unter Narendra Modi hat sich eine App bauen lassen und sammelt über die fleißig Daten ihrer Unterstützer. Damit verschafft sich die Partei einen enormen Vorteil für KI-basierte, auf kleinste Gruppen feinabgestimmte Wahlkampagnen. (Bericht bei Rest of World)

Zugegeben: auch das hat der BJP am Ende keinen Sieg verschafft, und viele Wissenschaftler glauben, dass Dunkelmänner wie Cambridge Analytica letztlich nicht viel mehr bewirken, als dass sich ihre Kunden mal so richtig böse fühlen dürfen. Aber dass all dieser riesige Tech-Aufwand gar keine Folgen für Demokratie und Gesellschaft hätte: will man sich darauf verlassen?

Böse, kleine Pointe: Wenn meine Journalisten-Kolleg:innen und ich uns bemühen, KI als Unterstützung für die Recherche einzusetzen, ist das irgendwie auch putzig — weil die Waffen so ungleich verteilt sind. Während wir versuchen, uns kleine RAGs für die Recherche zu bauen oder Interviews mit KI-Dummys vorzubereiten, haben Organisationen mit genug Manpower und Finanzkraft das längst professionalisiert. Dass Tech-Herrscher wie Sam Altman, Sundar Pichai oder Satya Nadella irgendwie „relatable“ rüberkommen, hängt m.E. auch damit zusammen, dass sie sich genau vorhersagen lassen können, was sie wann wie sagen müssen — davon ist der Paranoiker in mir überzeugt.

KI ist eine hoch fragwürdige Technologie… und was schließe ich für mich daraus?

Ich experimentiere und arbeite eine Menge mit generativer KI. Dadurch habe ich im vergangenen Jahr API- und KI-Abo-Kosten von etwa tausend Euro gehabt. Ich habe für mich beschlossen: Für jeden Euro an eine der KI-Firmen spende ich einen Euro an eine Bürgerrechts- oder Umweltschutzorganisation. Wer da alles Geld von mir bekommt, kann man hier nachlesen.

Natürlich hat das etwas von Ablasshandel — aber was soll man sonst tun? Es ist ja einer der perfidesten Tricks der Großkonzerne, uns einzureden, dass letztlich nur wir mit unserem Verhalten die Verantwortung für den Zustand der Welt tragen. (Stichwort: CO2-Fußabdruck; quarks.de.)

Was nicht heißen soll, dass wir keine Verantwortung für das hätten, was wir gedankenlos tun — aber die Normen einer Gesellschaft entstehen durch Gesetze und Kampagnen. Ändern können wir nur zusammen etwas — wenn wir uns hinter Organisationen versammeln, deren Zweck ist, genau solche Normen zu erreichen: für transparente KI, deren Risiken reguliert werden; dafür, die Apples, Microsofts und Musks dieser Welt in die Verantwortung zu nehmen, für einen konsequenteren Kampf gegen die Klimakatastrophe gerade in Hinblick auf den rapide steigenden Energieverbrauch durch KI.

Auch lesenswert:

- Die Psychologie der KI – die 8 größten Irrtümer

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Prompting-Formeln sind Bullshit. Hier ist meine.

Schreibe einen Kommentar