KI-getriebene, dokumentenbasierte Chatbots als neue journalistische Form: Warum ich hoffe, dass journalistische Medien ihre großen Recherchen jetzt auch in diese neue Form bringen – und ein paar Tipps, wie man anfangen könnte.

Digitale Artikel sind nie ganz fertig. Wenn es um ein wirklich tiefes Thema geht, werden die Nutzerinnen und Nutzer immer noch Fragen haben, und das ist ihr gutes Recht. Ohnehin sollten wir nicht annehmen, dass jemand mehr als nur die Überschrift gelesen hat. Je mehr KI-Chatbots wie ChatGPT Teil unseres Alltags werden, wirkt sich das aus: Suchen ist oldschool, Fragen ist das neue Googlen. Also sollten wir unsere Recherchen in Formen anbieten, die das erlauben; bei allen Problemen, zu denen wir später noch kommen. Aber vielleicht erreichen wir so Nutzerinnen und Nutzer, die sonst für den professionellen Journalismus verloren sind.

Der Chatbot, der die Wahrheit finden hilft

Wie gegen Netzlügen kämpfen? Das brasilianische Investigativportal Aos Fatos („Die Fakten“) bietet einen Desinformations-Radar und jede Menge Faktenchecks. Der Bedarf und auch die Nachfrage nach diesen Faktenchecks war im brasilianischen Präsidentschafts-Wahlkampf groß – aber die Redaktion beobachtete: Nutzerinnen und Nutzer sind tendenziell unwillig, sich den entsprechenden Artikel zu suchen und zu lesen. Aber wenn sie ihre Fragen direkt stellen konnten, blieben sie. (Nieman Lab) Also hat Aos Fatos FátimaGPT gebaut, einen Chatbot, der auf Basis der Faktenchecks des Portals Fragen der Nutzerinnen und Nutzer beantwortet.

Der Bot, der natürlich Links zu den Belegen und ausführlichen Artikeln liefert, ist inzwischen bei Version 3.0 angekommen (Aos Fatos via Google Translate): ein RAG, ein KI-Assistent also, der für seine Antworten auf die hinterlegten Dokumente zurückgreift.

Dokumentbasierte RAG-Assistenten haben Vorteile: So halluziniert der Bot nicht so sehr, und nutzt den reichen Schatz an mühsam zusammenrecherchierten Informationen, den auch alt gediente Redakteurinnen nicht immer im Kopf haben. Aus demselben Grund nutzt das Team des Formats „Dein Argument“ beim BR einen ähnlichen Bot intern, um Antwort-Entwürfe auf Nutzerfragen vorzubereiten (mehr bei ▶️ br.de).

KI hilft Versuchspersonen aus dem Kaninchenloch

Als rabbit hole – Kaninchenbau – bezeichnet man eine in sich geschlossene Welt, in die jemand abtaucht; in Anlehnung an „Alice im Wunderland„. Wahnwelten, in denen man sich verlieren konnte, gab es schon vor Internet und Social Media. Aber vor allem Youtube (▶️ Artikel in der NYT) und TikTok (▶️ Video des WSJ) stehen im Verdacht, Menschen regelrecht in Kaninchenbauten zu treiben: Zum einen bringen sie eine bislang beispiellose Zahl an Menschen mit Verschwörungsmythen in Kontakt – und liefern ihnen dann auch immer mehr davon, was ihnen hilft, Widersprüche auszublenden.

(Sehr unterhaltsamer Lesetipp zur psychologischen Begründung dieses Mechanismus, der uns an einmal gewonnenen Überzeugungen festhalten lässt: “Mistakes were made, but not by me” – nicht nur der Titel dieses Sachbuchs ist großartig, und ihr werdet in Zukunft zweimal darüber nachdenken, eure Wut auszuleben.).

Radikalisiert durchs böse Internet? So einfach ist es leider nicht. Wissenschaftler sind sich inzwischen einigermaßen sicher: Allein durch Youtube, TikTok und Co. wird niemand vom Vernunftmenschen zum Aluhutträger. Die viel wichtigere Frage ist aber: wie bekommt man die Menschen wieder aus den rabbit holes heraus? Mit Faktenchecks allein ist faktenresistenten Menschen leider nicht beizukommen (▶️ First Draft) – und journalistischen Medien glauben sie ohnehin nicht. Was tun? Eine Antwort könnten, tatsächlich, KI-Chatbots bieten.

Reden hilft!

Ein simpler Auftrag an die KI: Überzeuge dein Gegenüber, dass es sich beim Glauben an [Aliens, eine JFK-Verschwörung, massenhaft vertuschte Impfschäden] um eine Verschwörungstheorie handelt. Drei Forscher untersuchten, welche Wirkung es auf Verschwörungsgläubige hat, sich mit einer so gebrieften KI zu unterhalten – und stellten fest, dass der Dialog mit dem Chatbot das Vertrauen auf die Richtigkeit der Verschwörungserzählung um etwa ein Fünftel senkte. Nachhaltig. Der Herausgeber des Science-Magazins, in dem die begutachtete Studie erschien, fasst zusammen:

„Die Fähigkeit des Chatbots, passende Gegenargumente und personalisierte Gespräche mit Substanz aufrecht zu erhalten, hat ihren Glauben an Verschwörungen auf Monate vermindert, was bisherige Forschungsergebnisse infrage stellt, nachdem man diesen Glauben nicht ändern kann.“

Wer sich anschauen will, wie das aussieht: Das ▶️ Nieman Lab hat ein paar Beispiel-Dialoge aufgearbeitet – und natürlich den Link zur ganzen Studie.

Erste Schritte: Was packe ich in die Wissensbasis?

Im Alltag wird es weniger um Flache-Erde-Gläubige gehen als um Menschen, die mehr über die Welt vor ihrer Haustür wissen wollen. Wie kann man ihnen einen Bot anbieten? Spielen wir das mal an einem Beispiel durch.

Sagen wir, wir haben eine Recherche zu Windrädern in Hessen – wo sie stehen, wie lang sie gebaut wurden, was sie kosten und was sie bringen, was die Anwohner sagen. Und wir überlegen, ein „Custom GPT“ zu bauen — die OpenAI-Variante der RAG-Assistenten-Technik für ChatGPT-Abokunden (kurze Praxiseinführung und kostengünstige Übungs-Alternative hier).

In der Recherche sind jede Menge Notizen aufgelaufen, und Forschungsberichte und Studienergebnisse haben die eifrigen Reporter auch gesammelt. Jetzt könnten wir all diese Dokumente in „Custom GPT“ hochladen. Sollten wir aber nicht tun. Ähnlich wie in der Suchmaschinenoptimierung sollten wir darüber nachdenken, was unsere Nutzerinnen und Nutzer eigentlich wollen: Welche Fragen könnten sie haben, und wie können wir die Antworten schon so vorbereiten, dass der Chatbot sie direkt geben kann?

Das heißt, dass wir die wichtigsten Ergebnisse der Recherche kondensieren, damit die KI das gelieferte Material einordnen kann — wir schreiben der KI ein Briefing. Und es ist eine gute Idee, sich (und dem Chatbot) eine FAQ zu schreiben – eine Liste mit Beispielantworten auf die häufigsten Fragen. Dabei auch gerne grundsätzlich werden: Wissenschaftler haben belegt, von der Erregung über Windräder bis zu handfesten Verschwörungserzählungen oft nicht mehr so weit ist (▶️ Ars Technica). Deshalb sollten wir ein paar Fakten zu den Gruselwörtern wie „Vogeltod“ aufbereitet haben, damit der Chatbot auf Basis dieser Fakten argumentieren kann.

Dokumenten-Chatbot-Tipps

RKI-Protokolle und Podcast-Transkripte: die Anwendungen der RAG-Technik war ja schon öfter Thema hier, einige der Erkenntnisse und Tipps nochmal ganz kurz zusammengefasst:

- Texte so gut wie möglich vorstrukturieren: Viel mit Zwischenüberschriften und Informationen zum Kontext arbeiten

- Wenn möglich, Textdateien verwenden und keine PDF. Am allerbesten im nerdfreundlichen Markdown-Format.

- Keine Wunder erwarten. Die KI wird tendenziell nicht vollständig antworten, und den Gesamtüberblick über die Recherche kann sie sich aus den Dokumenten auch nicht verschaffen; den müssen schon wir zusammenschreiben.

Kleine Paranoia-Anmerkung: Es ist nicht zu schwer, Prompts und Dokumente aus einem Chatbot wieder herauszufragen. Man sollte also in jedem Fall davon ausgehen, dass nichts geheim bleibt, was man in den Dokumenten oder im Prompt hinterlegt. Aber das ist ja für die meisten Projekte kein Problem.

…und warum lassen wir das nicht gleich Google machen? Oder Microsoft? Oder OpenAI?

Letzten Endes ist das, was wir hier selbst basteln, genau das, wo Google hinwill: Die KI liest die Artikel für uns und antwortet dann auf unsere Fragen. Es hat keinen Sinn, als einzelne Redaktion mit den Ingenieurshorden im Silicon Valley konkurrieren zu wollen – aber wenn wir einen Bot genau für unseren einen Anwendungsfall konstruieren, können wir steuern, welche Informationen er wie nutzt.

Das führt zu wesentlich besseren Ergebnissen, und so richtig reif ist die Technik bei den Technikriesen noch nicht: was sich KI-Suchassistenten von Google (▶️ BBC) und Microsoft (▶️ hessenschau.de) schon geleistet haben, ist ziemlich gruselig.

…aber Halluzinationen und Trolle?

Leider verhindern auch RAGs nicht, dass ein Sprachmodell Details einfach erfindet. Halluzinationen kann man auch mit einem dokumentbasierten Bot nie völlig ausschließen, und wir können auch nie ausschließen, dass neugierige Nutzer Unsinns-Antworten aus dem Bot gezielt herausfragen. Deshalb müssen wir die Nutzerinnen und Nutzer darauf hinweisen, dass es ein KI-Chatbot ist, kein Orakel und keine Pressestelle: Die KI versucht, auf Basis der hinterlegten Dokumente eine möglichst gute Antwort zu geben – sie kann sich dabei irren. Definitive Antworten gibt sie nicht.

Wenn der Chatbot für eine bestimmte Recherche oder ein bestimmtes Projekt gebaut ist, kann man ihn so konstruieren, dass er nicht wegläuft. Der “EVI-Checker” des MedWatch-Portals hilft Menschen, die sich über unseriöse Wirk-Versprechen bei Keto-Gummibärchen, hochdosierten Vitaminen oder Algen-Nasenspray aufregen. Allerdings arbeitet hier eben kein reiner KI-Chatbot, der sich die passenden Antworten aus den hinterlegten Dokumenten sucht (oder manchmal eben auch nicht). Die Nutzerin wird durch vorbereitete Fragen geführt – die KI ist in eine feste Regelstruktur eingebettet, die verhindert, dass die Nutzer oder der Bot sich verlaufen.

Wie man Leitplanken für eine KI einzieht, also: wie man eine vorher nicht festgelegte Konversation mit der KI daran hindert, völlig abzudriften, das kann man sich bei „Evertrail“ abschauen, einer KI-getriebenen Online-Fantasy-Geschichte mit Nutzerbeteiligung (Interview mit dem Macher von „Evertrail“ hier im Blog.).

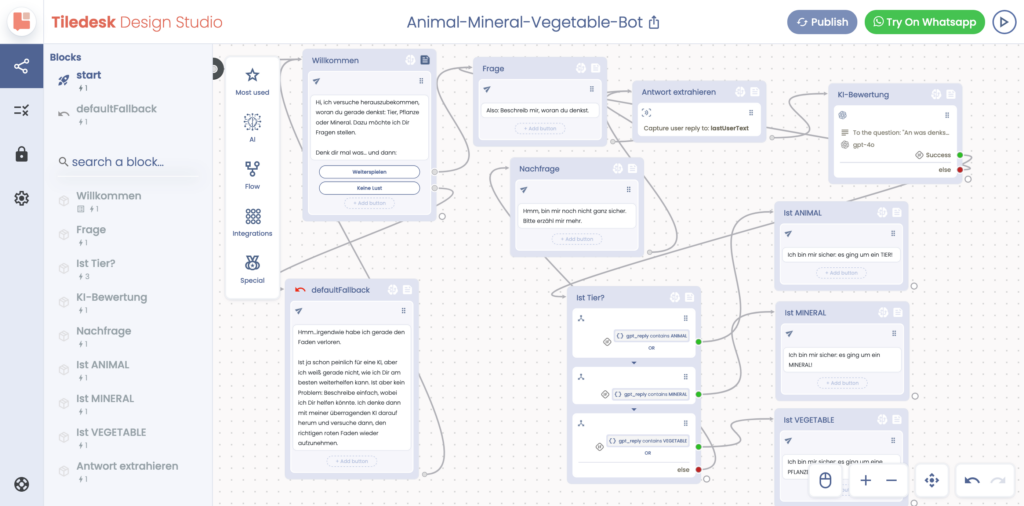

Tooltipp: Chatbots zusammenklicken!

So etwas wie den „EVI-Checker“ kann man sich selbst basteln, ohne Programmierkenntnisse. Wie es sich für einen eindeutig zu technikverliebten Blogger gehört, ende ich mit einem Tooltipp: Tiledesk ist eine Plattform, auf der man sich Chatbots aus Fertigbauteilen zusammenstecken kann.

Tiledesk — und das etwas teuerere amerikanische Vorbild Voiceflow — kommen aus der Welt der Sprachassistenten: Hier kann man mit wenigen Klicks einen Kundenservice für Alexa und Co. zusammenbasteln; das zentrale Konzept sind dabei so genannte „Intents“; Schlüsselwörter, an denen das Programm erkennt, dass es eine bestimmte Aktion auslösen soll. Aber die Bots können inzwischen cleverer sein als ein Alexa-Skill, wenn man KI einbaut – um Nutzerantworten auszuwerten, aber auch, um eine Antwort zu formulieren.

Funktioniert leider auch für Propaganda

Eins noch: Das Rezept funktioniert natürlich auch in die andere Richtung. Gut, wie sehr KI von Propagandisten und digitalen Meinungsmachern schon eingesetzt wird, überschätze ich vielleicht, aber ich bin fest überzeugt: KI-Chatbots mit Propaganda-Auftrag sind längst in den sozialen Medien unterwegs – das hat es ja sogar schon in die Internet-Popkultur geschafft (▶️ Know your Meme).

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Prompting-Formeln sind Bullshit. Hier ist meine.

- Fallstudie: Ein Community-Management-Chatbot mit Fachwissen – und ein nützliches kleines Tool!

Schreibe einen Kommentar