Ein peinlicher Interview-Moment wirft die Frage auf: Beruhen generative KI auf geistigem Diebstahl? Zeit, das zentrale Dilemma um die Urheberrechte aufzudröseln.

Vorweg eine Warnung: Hier spielen rechtliche Fragen eine Rolle, noch dazu in völlig unterschiedlichen Rechtssystemen – dem amerikanischen und dem deutschen. Ich kann und will zu den juristischen Fragen nichts Substanzielles sagen, sondern nur meinen halb technischen Journalistenblick auf sie richten. Trägt dieser Post trotzdem etwas zur (Er-)Klärung von Urheberrechtsfragen bei?

Ich sage mal: Das kommt darauf an.

Die OpenAI-Technikchefin gibt die Ahnungslose

Der Anlass ist SORA, der beeindruckende bis beängstigende Videogenerator von OpenAI. Bislang nur in Form von Demo-Videos sichtbar, vielleicht in der zweiten Jahreshälfte veröffentlicht (The Verge). Die Tech-Journalistin Joanna Stern vom Wall Street Journal konnte ein paar Prompts ausprobieren und zudem die OpenAI-Technikchefin Mira Murati dazu befragen. Das sehenswerte 10-Minuten-Video enthält gute Erklärungen und Beispiele zu den Stärken und Schwächen von SORA, und dann etwa bei der Hälfte, diesen Austausch:

Joanna Stern: „Welche Daten wurden benutzt, um Sora zu trainieren?“

Mira Murati: „Wir haben öffentlich verfügbare Daten und lizensierte Daten genutzt.“

Stern: „Also Videos von Youtube.“

Murati: (verzieht das Gesicht)

Der Moment ist nicht gezielt hereingeschnitten; nach einer Schrecksekunde fährt die OpenAI-Managerin mit einer Nicht-Antwort fort. Youtube? Keine Ahnung. Sie deutet an, ja, man könnte Videos von Facebook und Instagram verwendet haben, „wenn sie öffentlich zugänglich sind“, aber windet sich dann wieder heraus.

Das Internet war not amused:

Und sofort fallen einem all die kleinen Details wieder ein. Dass Sprachmodelle wie Llama2 nachgewiesenermaßen mit einem Textkorpus namens Books3 trainiert wurden, der tausende raubkopierte Bücher enthält. (The Atlantic) Dass OpenAI und Partner Microsoft für ihren Bildgenerator Dall-E diese merkwürdige Generalgarantie abgeben, dass sie schon einspringen, wenn es Urheberrechts-Ärger gibt. Dass der Datensatz von Stable Diffusion jede Menge persönlicher Bilder gesammelt hat – und die dazugehörenden Daten wie den Namen und Hinweise auf den Wohnort – wie das BR AI Lab recherchiert und beschrieben hat.

Das Dilemma

„Gegen den Diebstahl geistigen Eigentums durch KI generierte Sprachmodelle!“ (Linkedin-Post einer Verlegerin)

Stehlen KI-Großkonzerne unsere geistige Arbeit, um damit reicher zu werden? Ein Teil von mir rebelliert gegen diese Deutung; ich denke: so einfach ist es nicht. Wäre nach dieser Deutung nicht auch unzulässig, sich aus bestehenden Bildern einen neuen Mal-Stil anzueignen – wenn der Künstler dem nicht zugestimmt hat?

Tatsächlich möchte ich argumentieren, dass die Arbeitsweise von generativer KI – Bild, Video, aber auch Text – unterschiedlich interpretiert werden kann.

Welcher Interpretation sich Richter und Anwälte weltweit schließlich anschließen werden, kann ich nicht sagen – aber ich halte sie beide für grundsätzlich diskutierbar.

Das Argument: Generative KI ist eine Art Kompressionsverfahren.

Bei vielen, die die Rechtsrisiken von generativer KI beurteilen müssen, höre ich sehr viel Vorsicht heraus – was verständlich ist, weil vieles noch nicht geklärt ist. In der KI-Frühzeit schien mir das oft auch auf ein Missverständnis zurückzugehen: Die Vorstellung, dass ein KI-Bildgenerator im Internet nach passenden Bildern sucht – und dann so eine Art Collage bastelt, unter Ignoranz der Urheberrechte.

Bildgeneratoren haben keinen Zugang zum Internet – aber haben sie die Bilder, die sie im Training gesehen haben, nicht doch irgendwie gespeichert? In einem neuronalen Netz und sehr reduziert – aber eben, nach einer Transformation in Gewichte im Netz, doch als eine Art Abbild, das die KI dann wiedergibt?

Auf der technischen Seite gibt es ein paar Argumente, die dafür sprechen:

- Viele der erstaunlichen Intelligenzleistungen von Sprachmodellen scheinen letztlich darauf zurückzugehen, dass irgendwo jemand im Training schon mal genau diese Frage gestellt hat. In den Terabytes an Trainings-Daten sind einfach unfassbar viele Antworten schon drin – Analogie-Schlüsse zu ziehen oder zu generalisieren, scheint Sprachmodellen deutlich seltener zu gelingen, als wir denken. Sagt unter anderem dieses Paper.

- Es ist möglich, die Ursprungs-Inhalte aus einem Sprachmodell wieder herauszufragen. Je genauer man fragt – und je kleiner die Nische ist, mit der sich beispielsweise ein Text beschäftigt – desto wahrscheinlicher ist, dass das gelingt. Das ist einer der Streitpunkte zwischen der New York Times und OpenAI in der NYT-Klage gegen ChatGPT. Auch aus den neuronalen Netzen von Bildgeneratoren kann man einiges an Originalbildern extrahieren, sagt mir ein Bildforensiker.

Wenn wir der Interpretation folgen, dass Inhalte in einem generativen Modell komprimiert gespeichert sind, können wir Kompressionsraten berechnen. Wir kennen das aus der Bildbearbeitung: Je höher komprimiert wir ein Bild abspeichern, desto schlechter wird die Qualität. Normale Fotos im Netz werden etwa mit 1:10 komprimiert, um als JPEG- oder WEBP-Datei gespeichert zu werden. Für das Sprachmodell GPT-3, den unmittelbaren ChatGPT-Vorläufer, errechne ich eine Kompressionsrate von etwa 1:128.

Bilder allerdings enthalten deutlich mehr Daten. Die im LAION-Datensatz verlinkten Bilder sind eher klein; auf Basis der häufigsten Bildgrößen (LAION-Statistik) rechne ich mal mit einem Bild von 512×256 Pixeln. Das wären etwa 400kb je Bild – in einem Datensatz mit 5,8 Milliarden Bildern Das entspräche dann ungefähr 2 Petabytes an Daten, die zu einem Stable-Diffusion-Modell führen, das ungefähr 7 GB an Daten umfasst – also mit einer Kompressionsrate von ungefähr 1:350.000.

Das Argument: Generative KI kopiert nicht, sie lernt.

Und das spricht gegen die Sichtweise von KI als Kompressionsalgorithmus:

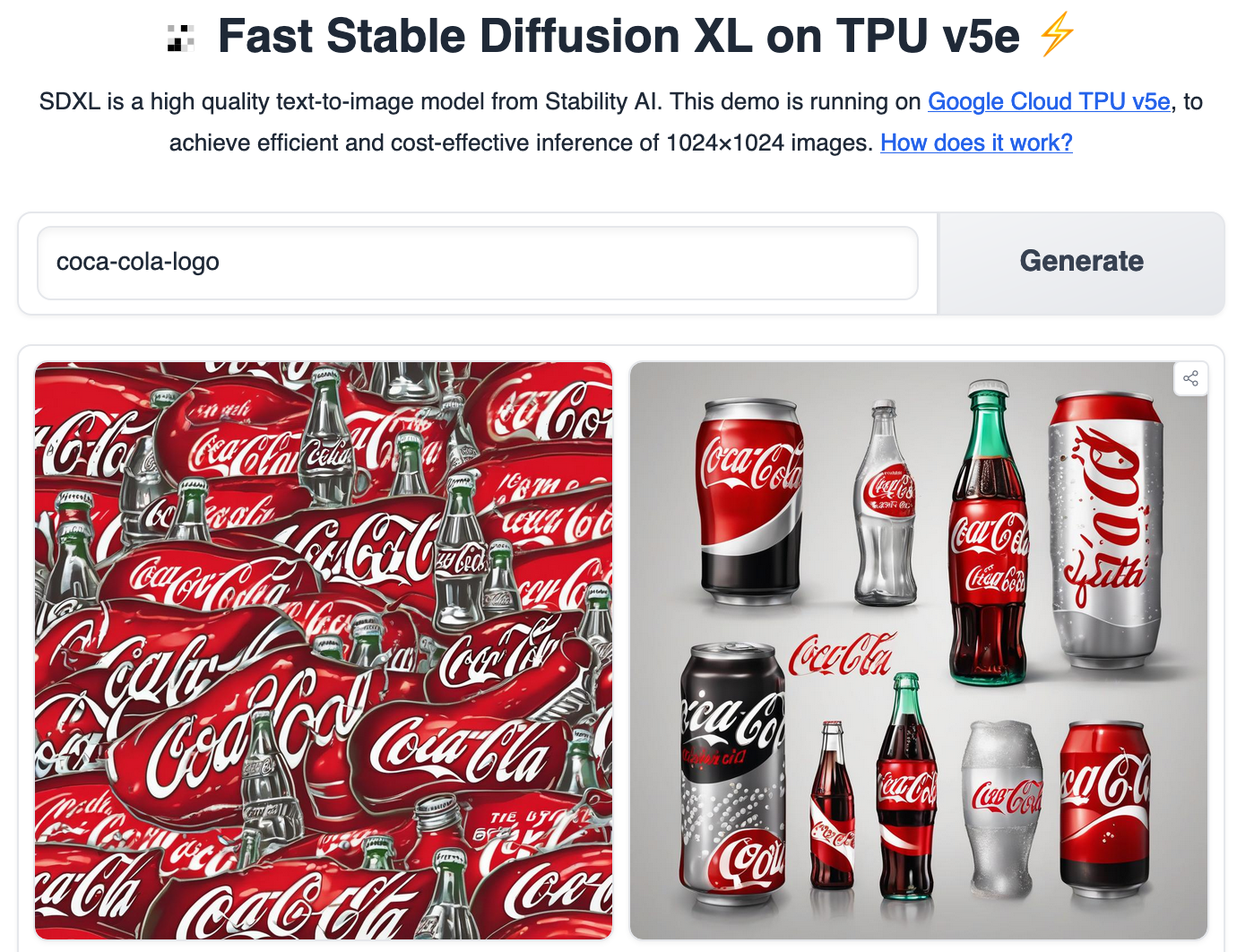

- Bei einer derart hohen Kompression kann man schlecht von einer verlustbehafteten Wiedergabe sprechen. Einfaches Experiment: Sich ein „Coca-Cola-Logo“ generieren lassen – es wird relativ klar, dass das keine Reproduktion ist.

- Bildgeneratoren rekombinieren Teile aus unüberschaubar vielen Bildern.

- Wie stark der Zufall ins Ergebnis spielt. Selbst bei einer einfachen Frage mit einer eindeutigen Lösung und ganz heruntergedrehtem Zufallsregler sind die genauen Ergebnisse eines Textgenerators nicht deterministisch. Und bei Bildgeneratoren führt zweimal derselbe Prompt eben nicht zu zweimal demselben Bild – selbst mit ausdrücklich angegebenen Referenz-Bildern nicht. (Weshalb Midjourney jetzt einen neuen Trick eingebaut bekommen hat; mehr dazu im Nachsatz.)

Das deutsche Urheberrecht gibt den Anhängern der Interpretation gute juristische Argumente. „Text- und Data Mining ist die automatisierte Analyse (…), um daraus Informationen insbesondere über Muster, Trends und Korrelationen zu gewinnen“, sagt das Urheberrechtsgesetz, und erklärt Data Mining für zulässig – wenn der Rechte-Inhaber der Nutzung nicht in maschinenlesbarer Form widersprochen hat. Für wissenschaftliche Forschung und nichtkommerzielle Zwecke ist Data Mining zulässig. (Was einer der Gründe ist, dass LAION, die Datensammler für Stable Diffusion, sich als Verein organisiert haben.)

Das heißt aber nicht, dass diese Interpretation in Stein gemeißelt ist. Man könnte auch argumentieren, dass die Data-Mining-Definition des Urheberrechts auf generative KI nicht zutrifft.

Viel wichtiger: Darf ich das jetzt…?

Auf See und vor Gericht sei man in Gottes Hand, heißt es. Die Unsicherheit überträgt sich auf uns Nutzerinnen und Nutzer: Ist jedes Midjourney- oder StableDiffusion-Bild, das ich hier in mein Blog stelle, ein Tropfen Blut, der irgendwann unweigerlich die Abmahn-Haie anlockt?

Nicht verunsichern lassen. Man muss die Juristen etwas quälen, um brauchbare Aussagen zu kriegen – aber sie sagen einem dann schon, dass die Frage: „Verletzen die Bildgeneratoren Urheberrechte?“ eine andere Frage ist als: „Verletzen die Bilder, die ich damit produziere, Urheberrechte?“ Und dass die allerwahrscheinlichste Antwort auf die zweite Frage ist: „Nö“. Das Risiko erscheint mir also vertretbar gering; ich gehe davon aus: wenn ich Bilder generiere, tue ich das auf dem Boden der Rechtsordnung.

Was natürlich nicht heißt, dass man mit Bildgeneratoren keinen rechtlichen Unfug anstellen kann.

Nachsatz: Midjourney kann jetzt Charaktere

Seit Mitte März kann man #midjourney mit dem Parameter –cref <url> das Bild einer „Character Reference“ übergeben, eines Vorbilds für die dargestellte Person. Mit realem Foto funktioniert das zum Glück nicht so richtig überzeugend, aber für gezeichnete Charaktere ist es eine deutliche Verbesserung, insbesondere in Kombination mit einem Stil-Muster, das man über –sref übergibt.

Genau das habe ich beim Titelbild für diesen Beitrag gemacht: Er übergibt das Bild von Mina Murati als Charakter-Vorbild, das Bild des Radkappen stehlenden Affen als Bild-Referenz. Der komplette Prompt: „/IMAGINE a monkey robot stealing a hubcap https://s.mj.run/GMD0KZMHZeo –v 6.0 –cref https://s.mj.run/gyYeLNT7SHk“

Auch damit hat es ein paar Versuche gebraucht.

Auch lesenswert:

- Die Psychologie der KI – die 8 größten Irrtümer

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Weshalb du als Mensch mit Gewissen und Verantwortungsgefühl keine KI verwenden solltest (zumindest nicht unkritisch)

Schreibe einen Kommentar