KI-Chatbots können inzwischen richtig gut recherchieren — die Betonung liegt auf: können. Zum einen spielt immer noch der böse Zufall eine Rolle. Zum anderen muss man die Sprachmodelle erst einmal dazu bringen. Dafür haben viele Chatbots inzwischen einen Recherche-Modus: Ein kleiner Überblick.

Als Beispiel erteile ich einen Suchauftrag, den ich bewusst ein wenig unscharf formuliere:

Da ich die Frage neulich für eine Episode für „hr2 Der Tag“ unter dem Titel: KI an, Hirn aus? recherchiert habe, weiß ich, dass man dabei unter anderem auf diesen wissenschaftliche Quellen stoßen könnte:

- die „Taxifahrer-Studie“, die nachwies: Bei Londoner Cabbies, die ihren Orientierungssinn ständig gut forderten, bildete sich die Hippocampus-Region aus (Maguire et al. 2000, via 🌐 PNAS)

- Längsschnittstudien, die mit Simulationen nachweisen, wie sich die Navigationsfähigkeiten zurückbilden: „Use it or lose it“ (u.a. Dahmani/Bohbot 2020, via 🌐 Pubmed)

- eine relativ neue Überblicksarbeit, die 20 Jahre Forschung rund um Navis und Gehirne zusammenfasst (Miola et al. 2024, via 🌐 ScienceDirect)

Die KI erst einmal zum Suchen bringen

Wer im Alltag ChatGPT nutzt, weiß, dass man auch mit der Kostenlos-Variante im Netz recherchieren kann – aber auch, dass es zum Teil gar nicht so einfach ist, sie dazu zu bringen. Und dass wir Nutzerinnen und Nutzer genau hinschauen müssen, ob die KI wirklich ins Netz suchen gegangen ist oder sich Informationen vielleicht nur ausgedacht hat.

Wer die ChatGPT-Plus-Variante hat, ist da inzwischen Besseres gewöhnt: Die modernere o3-KI braucht als so genanntes „Reasoning-Modell“ zwar etwas länger, aber recherchiert weitgehend selbstständig und ziemlich gründlich. Mir ist das das erste Mal bei der Geschichte mit meinem Friseur, einem Flyer und der Bekämpfung von Ölpest sehr deutlich geworden.

o3-KI für ChatGPT-Bezahlkunden setzt Maßstäbe

Die Standard-KI für normale ChatGPT-Konten, das Sprachmodell, heißt GPT-4o. Bezahlkundinnen können oben links noch andere KI-Modelle auswählen – darunter auch o3. Allerdings patzt o3 beim ersten Versuch — erst ein Zauberwörtchen wie „Faktencheck“, „Hintergrund“, oder eben: „Recherchiere!“ bringt das o3-Modell dazu, Suchwerkzeuge einzusetzen — und seine agentischen Fähigkeiten.

Die Standard-KI für normale ChatGPT-Konten, das Sprachmodell, heißt GPT-4o. Bezahlkundinnen können oben links noch andere KI-Modelle auswählen – darunter auch o3. Allerdings patzt o3 beim ersten Versuch — erst ein Zauberwörtchen wie „Faktencheck“, „Hintergrund“, oder eben: „Recherchiere!“ bringt das o3-Modell dazu, Suchwerkzeuge einzusetzen — und seine agentischen Fähigkeiten.

Die o3-Suche erstellt sich einen Rechercheplan, sucht Informationen, wertet sie aus, sucht erneut, schreibt das Ergebnis kompkat zusammen. Und trifft zumindest für meinen Geschmack eine gute Balance zwischen umfangreich und übersichtlich: das kann im Redaktionsalltag sehr nützlich sein, um sich schnell in ein Thema einzulesen. Und es geht schnell.

In meiner 🌐 o3-Beispielsuche listet sie alle Quellen auf, die ich erwartet hätte, und benennt auch Grenzen der Recherche: Glück gehabt! (Denn natürlich ist das Ergebnis nicht immer so gut — zu den Dingen, die wir weiter im Blick haben müssen, mehr gegen Ende.)

- Stärken: schnell, kompakt, gründlich

- Schwächen: Auf Halluzinationen achten!

Von einem professionellen Faktenchecker gibt es eine Turbo-Variante. „Deep Background: Fact-checks and Context“ ist ein 🌐 Custom GPT, also ein vorkonfigurierter Spezial-Chatbot, der zu Fragen wie: „Leugnet die AfD wirklich den Klimawandel?“ tief gräbt und eine wohl begründete, abgewogene Einschätzung liefert. (🌐 Beispielsuche) Ersteller Mike Caulfield warnt allerdings davor, den Chatbot mit irgendetwas anderem als dem o3-Modell einzusetzen; wer das Standard-GPT4o-Modell nutzt, wird Unsinn bekommen. Zeigt im Umkehrschluss, wie gut o3 beim Recherchieren ist.

Wovon ich dagegen tatsächlich kein so großer Freund bin: von ChatGPTs „Deep Research“-Modus, den ich als Plus-Kunde ebenfalls ein paarmal im Monat nutzen dürfte. Wie bei Google Gemini ist mir das Ergebnis für den schnellen Überblick in der Regel nicht kompakt genug.

Mistral Deep Search

Ja, wieder einmal Mistral! Ich bin aus Gründen ein Freund des einzigen konkurrenzfähigen Chatbots aus Europa:

- erstens, weil nicht Musk, Zuckerberg oder Altman (oder die chinesische KP);

- zweitens und drittens, siehe erstens;

- viertens, weil man über das 🌐 Mistral-Reddit-Forum einen ziemlich kurzen Draht zum Kundenservice hat;

- vor allem aber, weil es bei Mistral inzwischen vieles kostenlos gibt, was bei ChatGPT kostet – und zum Teil besser.

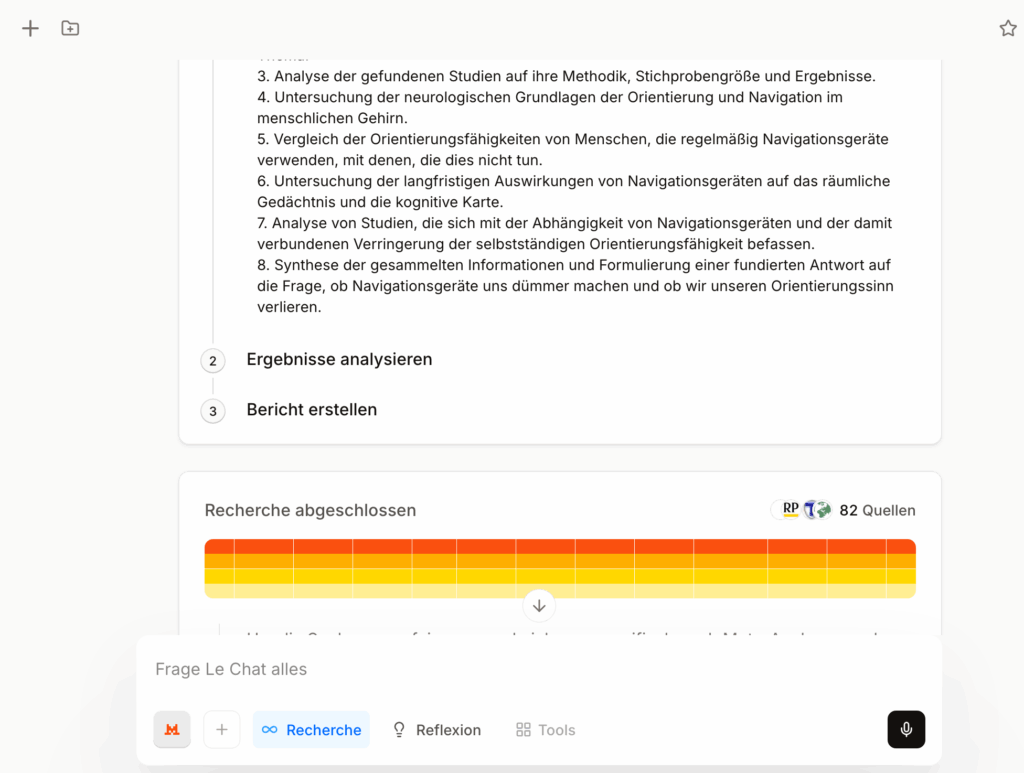

Wie jetzt eben den „Recherche“-Modus: Kostenloskunden haben 5 Suchen pro Monat frei, Bezahlkunden 35. Die Grundidee ist ähnlich wie bei anderen „Deep Research“-Agenten

Auch hier listet die 🌐 Beispiel-Recherche die Quellen auf, die ich erwartet hätte – und noch ein paar mehr. Dabei gerät dem Sprachmodell allerdings die Unterscheidung zwischen wissenschaftlichen Preprints und Zeitungsartikeln durcheinander: Nichts gegen RP Online als Quelle, aber es ist eben keine Studie! Außerdem scheint die Verlinkung der Quellen nicht durchgängig zu funktionieren; die Link-Knöpfe liefern zwar per Mouseover Detail-Infos, sind aber tot.

- Stärken: kompakt und blitzschnell

- Schwächen: Quellenwahl und -verlinkung, KI-Sprachmodell etwas schwächer

Google Gemini Deep Research

Der „Deep Research“-Modus bei Googles kostenlosem Chatbot 🌐 Gemini war erkennbar das Vorbild für den Recherche-Modus bei Mistral. Man bekommt ihn so: Das Flash-2.5-Modell auswählen und die Schaltfläche für „Deep Research“ anklicken. Wie bei Mistral fragt die KI zunächst, ob man mit dem Rechercheplan einverstanden ist, und produziert am Ende ein umfangreiches Dossier. SEHR umfangreich.

Das Ergebnis der Beispiel-Recherche umfasste 17 Seiten – die wesentlichen Quellen sind dabei; besonders alltagstauglich ist dieses Dossier aber nicht: Wer es nachlesen will: Man kann die Ergebnisse einfach in ein 🌐 Google Doc kopieren, und das habe ich getan.

- Stärken: wertet extrem viele Quellen aus

- Schwächen: Man braucht fast eine KI, um die Ergebnisse der KI auswerten zu können; dauert relativ lang

you.com

Die beiden KI-Such-Spezialisten you.com und perplexity.ai sind sich relativ ähnlich: Auch sie bieten „Deep Research“-Assistenten für tiefer gehende Recherchen. Bei 🌐 you.com – drei tiefe Recherchen im Monat sind frei – sind seit einigen Tagen laut Hersteller-Ankündigung die großen Brüder des o3-Modells im Einsatz.

Nachdem man seine Frage eingegeben hat, erstellt der Chatbot einen Rechercheplan, und wenn man in den nächsten 5 Sekunden nicht eingreift, legt er los – und ist nach etwa 30 Sekunden fertig.

In meiner 🌐 Beispiel-Recherche liest die KI in diesen 30 Sekunden nach eigenen Angaben 120 Quellen. Eine zentrale Rolle scheint aber eine einzelne, eher hinterfragenswerte Quelle zu spielen: Der KI-Bot hangelt sich für seine Zusammenfassung an einem Artikel der Bostoner Altenheim-Kette „Hebrew Senior Life“ entlang. Außerdem nervt mich der etwas gönnerhafte Standardton der KI. Das Ergebnis ist aber für den Redaktionalltag gut nutzbar, nicht so geschwätzig wie bei Google und ein guter Anlaufpunkt.

- Stärken: schnell, gute Usability, kompakt

- Schwächen: Quellenwahl, etwas onkelhaft im typischen KI-Schwafelton, setzt zentral auf eine Quelle

perplexity.ai

Für den Recherche-Modus der KI-Suchmaschine Perplexity braucht man ein (kostenloses) Nutzerkonto. Man erreicht ihn über den „Forschung“-Knopf am unteren Rand des Chat-Eingabefelds — der mittlere der drei kleinen Knöpfe. Drei Recherchen pro Tag sind mit einem Kostenlos-Konto frei. Er nimmt sich ähnlich viel Zeit wie Google Gemini, wenn die Recherche durch ist, schickt Perplexity eine E-Mail.

Die 🌐 Beispiel-Recherche wertet dann am Ende 72 Quellen aus — eine bunte Mischung aus Studien-Primärquellen und journalistischen Artikeln, was kein Fehler sein muss. Tatsächlich fühlt sich das Perplexity-Ergebnis rund an; die von mir als Prüfstein genutzten Studien sind zumindest indirekt referenziert.

Bei Perplexity bin ich allerdings extrem misstrauisch, was die Quellen angeht, auch weil ich außerhalb des „Forschungs“-Modus immer wieder beobachte, dass Perplexity kein gutes Händchen bei der Einschätzung von Quellen hat: beliebige LinkedIn-Posts, Einträge in Marketing-Blogs — und dann macht es auch nachweisbar einen Unterschied, ob man auf englisch oder auf Deutsch fragt. Also: Fragezeichen bei der Quellenwahl, auch wenn sie bei meiner Beispiel-„Forschung“ überzeugend ist.

- Stärken: umfassend und doch kompakt

- Schwächen: Quellenwahl?

Auf Unsinn checken müssen wir selber!

Ich unterstreiche noch einmal: Dass eine KI gut recherchieren kann, heißt leider nicht, dass sie es auch tut. Und ich habe auch bei den Assistenten die üblichen Fehler bemerkt. So habe ich erlebt, dass…

- die KI-Suchassistenten lieber Zeitungen zitierten als Wissenschaftler,

- Autoren erfunden wurden – und wenn man nachfragte, auch eine Quelle dazu, die es nicht gab,

- ein Assistent nicht verstand, was ein Tryptichon (ein dreiflügeliger Altar) ist,

- falsche logische Schlüsse gezogen wurden,

- die Quellen sehr unterschiedlich gelesen und ausgewertet wurden.

Es bleibt dabei: Bei KI Quellen selbst checken und hinterher recherchieren.

Als Lesetipp ein Verweis aufs 🌐 „Digital Digging“-Blog von Henk van Ess: Der Digital-Recherche-Spezialist wollte wissen, was Recherche-Assistenten taugen: Gemini DeepResearch, Perplexity DeepResearch, ChatGPT DeepResearch (wo haben sie nur den Namen her?) — und das ist ein ziemliches Blutbad geworden.

Beitragsbilder: Midjourney 6.1, Screenshots, halluzinierende KI: Phillipp Lenssen

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Die Psychologie der KI – die 8 größten Irrtümer

- Ich esse meine Worte: Das kann die KI inzwischen doch! Oder?

Schreibe einen Kommentar