Die neue europäische Mistral-KI ist ein Überflieger – verdankt sie den ihren Erfolg im Vergleich mit anderen KIs einem Talent zur Schleimerei? Weshalb dir deine KI sagt, was du hören willst.

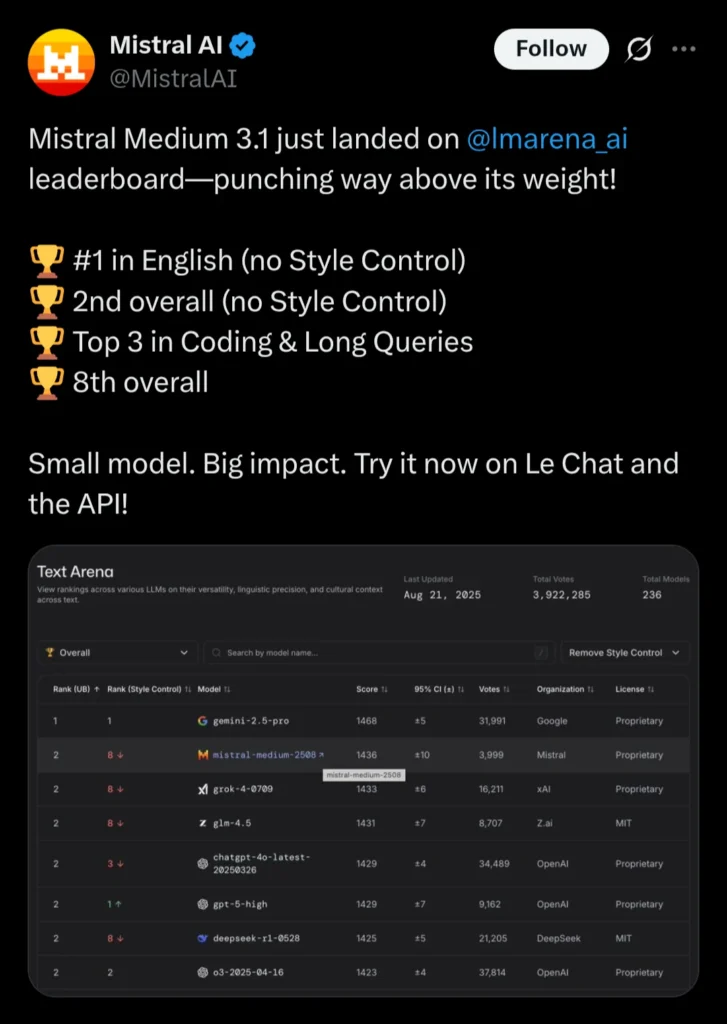

Dass ich ein Riesen-Fan von Mistral AI und dem „Le Chat“-Chatbot aus Frankreich bin, sage ich ja immer wieder — aus vielen Gründen. Deshalb hat mich auch elektrisiert, als den umtriebigen KI-Franzosen vorvorige Woche eine neue KI veröffentlicht haben – und damit das Feld aufgerollt:

Eine so hohe Platzierung im 🌐 LMARENA-Leaderboard sagt tatsächlich was aus: Dort beurteilen Nutzerinnen und Nutzer, welche von zwei zufällig ausgewählten KIs ihrer Ansicht nach besser auf ihre Fragen antwortet. Aus den Siegen in diesem KI-Battle kann man dann ein Ranking errechnen, nach derselben ELO-Methode, mit der man sonst Schachspieler bewertet.

Das gute Abschneiden von Mistral ist also eine große Sache. Zum einen, weil wir uns Europäern das ja nicht wirklich zutrauen im Vergleich mit den Tech-Riesen aus USA und China. Und das Mistral-Modell boxt technisch eigentlich in einer anderen Gewichtsklasse als die 800-Pfund-Gorillas GPT-5 von ChatGPT/OpenAI und Claude von Anthropic. Trotzdem, ein klein wenig Schummelei ist wohl dabei – genauer gesagt: ein klein wenig Schleimerei.Wie Mistral sich ein wenig besser schummelt

Wie jeder gute Tech-Verkäufer hat sich die Marketingabteilung von Mistral natürlich den einen Vergleich herausgesucht, bei dem sie vorne stehen: Im Ranking, das Mistral nach vorne schiebt, wurde die so so genannte „Style Control“ weggelassen. Die soll ausgleichen, dass wir uns durch wohlgesetzte Worte über dünnen Inhalt täuschen lassen.

Eine sehr mathematische Erklärung dieser „Style Control“ gibt’s bei 🌐 LMARENA, kurz gesagt kann man sich „Style Control“ als eine Art Strafpunkte-System für Schönrednerei vorstellen, Und nach Abzug dieser Strafpunkte war das Mistral-Modell nicht mehr vor GPT-5, aber immer noch auf einem achtbaren 8. Platz, den es sich mit einer Menge anderer Modelle teilt.

Was aber ist: Schönrednerei? Im Kern: das, was die Amerikaner „sycophancy“ nennen – die Fähigkeit, uns zu sagen, was wir hören wollen. Man könnte sagen, das neue Mistral-Modell lag auch deshalb vorn, weil es ein wenig besser schleimt als GPT-5. Aber an sich neigen alle Sprachmodelle dazu. Hat jeder schon mal erlebt: Die KI antwortet Unsinn, ich sage ihr: Das stimmt nicht, und sie wirft sich sozusagen winselnd vor mir auf den Boden wirft und sagt, sie sei ja so dankbar für die Korrektur. Aber es gibt auch deutlich weniger alberne Folgen.

Wenn Schleimerei tödlich wird

Schleimerei ist eine ernste Sache, nicht nur als politische Kategorie. Wenn KI-Chatbots uns in dem bestärken, was wir glauben wollen, kann das ernste Folgen haben. Eben haben in den USA trauernde Eltern OpenAI verklagt, weil sie ChatGPT eine Mitschuld am Suizid ihres 16-jährigen Sohnes geben – der Chatbot soll beispielsweise Methoden zur Selbsttötung empfohlen haben. (🌐 Spiegel.de)

Kreisen Ihre Gedanken darum, sich das Leben zu nehmen? Die Telefonseelsorge ist rund um die Uhr kostenfrei und anonym erreichbar unter der bundeseinheitlichen Telefonnummer: 0800 – 111 0 111 oder 0800 – 111 0 222. Weitere Informationen zu Hilfsangeboten – beispielsweise Selbsthilfegruppen – finden sich auf der Webseite der Deutschen Gesellschaft für Suizidprävention: suizidprophylaxe.de

KI-Chatbots sind als psychische Ratgeber eher ungeeignet, weil sie dazu neigen Selbsttäuschungen zu verstärken, sagt eine 🌐 MIT-Studie auf arxiv.org. Auch da, wo einem die KI nicht gerade eine geladene Waffe in die Hand drücken will, ist es ganz schön bedenklich, wenn der Chatbot auch faule Spiele mitspielt, um mir zu gefallen: Ob er Menschen darin bestärkt, dass sie genial sind und gerade einer ganz großen Verschwörung auf der Spur (🌐 New York Times); ob er hilft, aus dem Kaffeesatz Beweise für die Untreue des Ehemanns zu lesen (🌐 Greek City Times), oder mir vorspielt, er sei in mich verliebt. (🌐 Spiegel.de)

In all diesen Fällen kommen zwei Dinge zusammen: Halluzinationen — also plausibel klingende Erfindungen, die dort zum Einsatz kommen, wo es keine sicheren Fakten von der KI gibt — und die Neigung der KIs, uns zu sagen, was wir hören wollen.Warum KI schleimt

Verantwortlich für die Neigung zur Schleimerei ist eine Phase ihres Trainings: Wenn ein junges, mit Internettexten gefüttertes Sprachmodell vom Hersteller feingeschliffen wird, bekommt es gezeigt, welche Aussagen Menschen als gut bewerten und welche nicht. Und in diesem „Reinforcement Learning with Human Feedback“, kurz RLHF, lernen die Modelle, was wir hören wollen. Und wir mögen eben Antworten, die uns schmeicheln. (🌐 Schön erklärt von science.com: „Why AI chatbots lie to us“.)

Die KI-Firmen wollen natürlich, dass die Antworten des Chatbots uns gefallen. Der Wunsch, User auf der Seite zu halten, lässt sie an einer weiteren Stellschraube drehen: Über den so genannten „System Prompt“, der jeder Chatbot-Anfrage an die KI automatisch vorangestellt wird, können sie eine Art Persönlichkeit vorgeben – beispielsweise indem sie sagen: „Pass dich ann den Tonfall und die Stimmung des Nutzers an und übernimm seine Denkweise.“

OpenAI hatte es bei ChatGPT im April nachweislich übertrieben: Die Schleimerei stieß negativ auf; die Firma musste ein Update zurücknehmen. (🌐 Alberto Romero) Aber wenn sie die „sycophancy“ zurückschrauben, ist es auch wieder nicht recht: Nutzer beschweren sich in Foren, das deutlich weniger schmeichlerische GPT-5 sei kalt und unempathisch (🌐 Reddit). Und das ist sicher mit dafür verantwortlich, dass man jetzt wieder selbst auf die ältere GPT4o-KI umstellen kann, was OpenAI uns Durchschnittsusern eigentlich nicht mehr erlauben wollte.

Wie mein sehr KI-kundiger Kollege Sebastian Mondial sagt: Jede Nutzergruppe bekommt am Ende die KI, die sie erwartet – und damit bekommt auch vielleicht jede Nutzergruppe die KI, die sie verdient.

Auch lesenswert:

- Die Psychologie der KI – die 8 größten Irrtümer

- Prompting-Formeln sind Bullshit. Hier ist meine.

- Besser prompten: Gib der KI gut strukturierte ROMANE!

Schreibe einen Kommentar