„ChatGPT zum Herunterladen“ – das ist vereinfacht gesagt das, was OpenAI-Boss Sam Altman vorgestern verkündet hat. Hier geht es um die einfachen Fragen: Was brauche ich dafür, und wozu ist das überhaupt gut?

Dieser Artikel ist für alle, die chatgpt.com und ähnliche Dienste wie gemini.google.com oder chat.mistral.ai im Netz kennen und lieben, noch nie eine KI auf einem eigenen Computer installiert haben, aber das vielleicht mal gern probieren möchten: Seit 5. August 2025 kann sich jeder und jede eine Version der ChatGPT-KI auf eigene Rechner herunterladen. (🌐 OpenAI) Und wir wollen erst mal die ganz großen Fragen beantworten:

- Welche Hard- und Software brauche ich dafür?

- Weshalb sollte ich mir die Mühe überhaupt machen?

Eine weitere brennende Frage: Habe ich dann wirklich ChatGPT auf dem eigenen Laptop? Leider nicht ganz; was mit heruntergeladener KI möglich ist, wollen wir uns zum Schluss anschauen, ebenso wie die Konkurrenz. Denn OpenAI ist zwar der bislang größte Anbieter von KI zum Herunterladen, aber nicht der einzige – und auch gar nicht unbedingt der beste.

Worauf es ankommt: Grafikchips und Grafikspeicher

Mit KI ist wie mit anderen Computerprogrammen: Damit ich die KI – genauer: das KI-Modell – zum Laufen bringen kann, muss ich eine Datei auf meinen Rechner herunterladen. GPT-OSS, die neue KI-Schwester von ChatGPT, gibt es in zwei Ausführungen, jeweils mit einer ziemlich großen Datei:

- gpt-oss-20b, das kleinere Modell, ist 14 Gigabyte groß,

- gpt-oss-120b, die größere Variante, wiegt sage und schreibe 65 Gigabyte groß.

Zum Vergleich: Ein moderner Büro-Laptop hat heute in der Regel 16 GB Arbeitsspeicher – das würde für die kleinere Variante von gpt-oss also schon reichen. Allerdings erfordern KI-Modelle, dass der Computer eine Unzahl von Berechnungen parallel anstellt – und damit das schnell geht, nutzen sie die Grafikkarte und deren eigenen Speicher. (Im Prinzip kann auch die CPU des Computers die KI-Berechnungen ausführen, aber da er sie nacheinander ausführen muss, antwortet die KI seeeeeeeeeeeeeeeeeeeeeeeeeeeeeeehr langsam – Spaß macht das nicht.)

Also kommt es auf die Grafikkarte an. Gamer dürfen sich freuen: ein leistungsfähiger Grafikchip hilft, ist aber gar nicht so wichtig – entscheidend ist der Speicher, den die Grafikkarte nutzen kann. Dieses so genannte VRAM ist teuer und entsprechend knapp: Windows-Laptops dürften selten mehr als 4GB Grafikspeicher haben, und das ist aus KI-Nutzer-Perspektive doof.

Faustregel: Mein Computer muss mindestens so viel Grafikspeicher haben, wie die Datei mit der KI groß ist – plus 2-3 GB Reserve.

Wer einen Mac nutzt, ist bei KI im Vorteil: Auf Apple-Computern teilen sich Prozessor und Grafikchip den verfügbaren Speicher, und eine KI auf dem Computer kann fast den gesamten vorhandenen Speicher nutzen.

Ein fünf Jahre altes Macbook Air reicht dicke aus, um die kleinere Variante der neuen GPT-OSS-KI laufen zu lassen – vorausgesetzt, es hat 16GB Speicher. Für die große Variante gpt-oss-120b bräuchte man einen Speicher von 96GB. Und das dürfte auch den meisten Mac-Nutzern das selbstzufriedene Grinsen aus dem Gesicht tilgen – anders als auf Windows-Systemen kann man Speicher bei Macs nämlich nicht nachrüsten; wer zu wenig Speicher hat, muss halt auf einen neuen Mac sparen.

Ollama als das Betriebssystem für die eigene KI

So ähnlich, wie ich ein Betriebssystem brauche, damit die Textverarbeitung auf meinem Computer arbeiten kann, benötigt die KI eine Arbeitsumgebung. Die derzeit beste für Privatanwender heißt Ollama, ist aus einem Hobbyprojekt mit vielen begeisterten Mitwirkenden entstanden und deswegen kostenlos. Anders als viele andere „Open-Source„-Gemeinschaftsprojekte ist sie aber richtig einfach zu bedienen: Einfach von 🌐 ollama.com/download herunterladen, installieren, fertig!

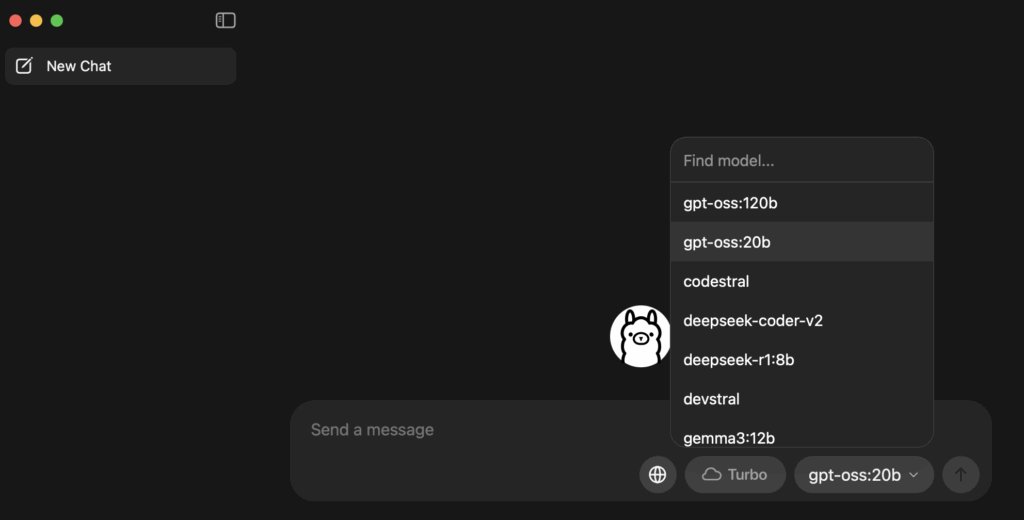

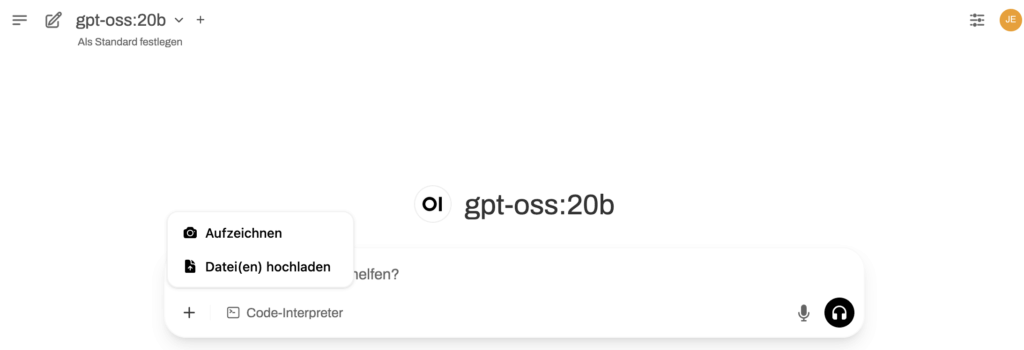

Ollama kümmert sich auch ums Herunterladen der eigentlichen KI: Wir müssen im Chatfenster rechts unten nur auswählen, welches KI-Modell wir nutzen wollen. Das muss natürlich auf unseren Rechner passen. Auf meinem alten 16GB-Macbook wäre also „gpt-oss:20b“ die erste Wahl – das muss dann einmal aus dem Netz heruntergeladen und auf meinem Rechner gespeichert werden, was einige Zeit dauert (wir erinnern uns: 14 Gigabyte!) Aber dann kann ich mit GPT-OSS genauso chatten wie mit der ChatGPT-Kostenlos-Version: ohne Anmeldung, und ohne irgendwelche Datenspuren zu hinterlassen.

Die KI ist jetzt auf meinem Rechner installiert. Wenn ich das Programm neu starte, dauert es meist ein wenig bis zu ersten Antwort: die KI muss erst wieder in den Speicher geladen werden. Übrigens merkt man, dass so eine KI ganz schön Arbeit bedeutet für Computer und Grafikchip: Der Rechner wird warm, spätestens bei der zweiten oder dritten Chat-Antwort springt der Lüfter an.

Die einmal installierte KI kann auch von anderen Programmen auf dem Rechner genutzt werden: Ich habe sie auf meinem Mac zum Beispiel in die Umgebung zum Programmieren eingeklinkt und kann mir jetzt von der lokalen KI Programmier-Tipps geben lassen (wie, habe ich schon vor einiger Zeit hier ausführlicher beschrieben).

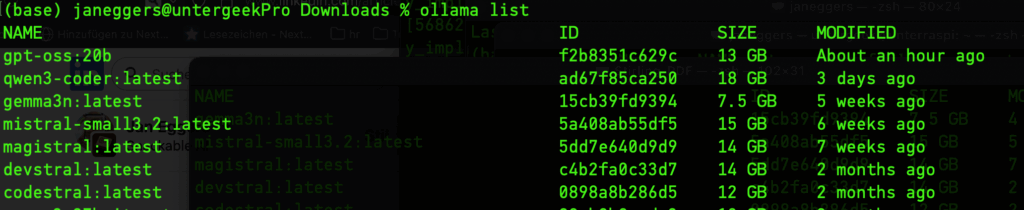

Wer sich traut, darf sich auch auf die Kommandozeile des Betriebssystem wagen und kann mit Kommandos wie „ollama list„, „ollama pull“ oder „ollama rm“ direkt steuern, welche KI-Modelle geladen sind.

Der Schritt auf die Kommandozeile ist auch gleich der Einstieg in Richtung Profi-Nutzeroberfläche: Der Chat, den Ollama eingebaut hat, ist sehr einfach, und vom Anbieter um wichtige Funktionen wie die Internet-Suche kastriert; da gibt’s Besseres.

Wer auf dem eigenen Rechner mit KI recherchieren will, eigene Dokumente als Wissens-Grundlage für die KI nutzen, Programmcode austesten oder Spracheingabe nutzen – der sollte sich unbedingt OpenWeb UI anschauen (🌐 Github-Repository). Das bekommt man aber nicht ohne Kommandozeile installiert, und möglichst auch nicht ohne einen so genannten Docker-Container; das ist dann schon fortgeschrittener Nerdlevel und benötigt einmalig ein wenig sanfte Unterstützung durch die IT-Versteherin deines Vertrauens.

Wozu es gut ist: KI und Daten unter Kontrolle

Stell dir einfach vor: Alles, was du bei ChatGPT und Co. eingibst, bleibt dort auf ewig gespeichert und könnte mehr oder weniger öffentlich werden. Wenn dich der Gedanke stört, ist eine lokale KI die richtige Wahl.

Das umfasst beispielsweise diese Anwendungsfälle:

- Wenn ich als Journalist:in an einer großen Geschichte arbeite. KI ist ein Super-Helfer, um alles gesammelte Wissen parat zu haben (Beispiel: die KI, die alle „Verurteilt“-Folgen kennt) und in den eigenen Recherche-Notizen nicht verloren zu gehen – wenn die vertraulich bleiben sollen, muss ich KI auf dem eigenen Rechner nutzen.

- Wenn ich einen Lebenslauf mit KI aufbereiten will – oder sogar eine Krankheitsgeschichte. Personenbezogene Daten haben nichts verloren in einem kostenlosen Cloud-Dienst wie ChatGPT. Die KI auf dem eigenen Rechner kann mir helfen, eine bessere Bewerbung zu schreiben, ohne dass mein Lebenslauf Teil der ChatGPT- oder Google-Trainingsdaten wird.

- Wenn ich KI nutzen will, wo ich kein Netz habe. Programmieren mit KI-Unterstützung im Zug: auf Strecken mit vielen Tunneln ein Alptraum. Die KI auf dem eigenen Rechner beendet ihn. Integration in die Programmier-Umgebung? Bitte hier entlang.

Was es leistet: Ist GPT-OSS wirklich ein kleines ChatGPT?

Faustregel: KI-Modelle auf dem eigenen Rechner spielen in einer Klasse mit den „Mini“-Modellen – oder dem ChatGPT von früher.

Okay: die KI-auf dem eigenen Laptop ersetzt nicht ChatGPT im Netz. Wäre ja auch dumm von OpenAI, wenn sie sich selbst das Wasser abgraben. So viel ist sicher, viel mehr noch nicht, weil wir das Modell ja alle erst noch ordentlich testen müssen.

Was ich von anderen lokalen KI-Modellen weiß: Die KI auf dem Laptop ist besonders dann überfordert, wenn man sie nach Fakten fragt. Schon bei einer Frage wie: „Was können Familien in Frankfurt unternehmen“, kommen sehr schnell Tipps zu Orten, die die KI einfach erfunden hat. Grund: Was ein KI-Modell „weiß“, muss für unseren bescheidenen Laptop deutlich stärker verdichtet werden. Und da die KI im einfachen Ollama-Chat nicht im Internet suchen kann, füllt sie Wissenslücken mit Halluzinationen.

Ganz ehrlich: das wäre für das ChatGPT von vor zwei Jahren noch ganz normal gewesen. Dass uns das oft nicht reicht, hat weniger mit den Beschränkungen der lokalen Modelle zu tun als mit den enormen Fortschritten, die die ChatGPT inzwischen gemacht hat. Und für diese Dinge ist selbst die kleine Version von gpt-oss allemal gut genug:

- Arbeit mit Texten (zum Beispiel: als Korrekturassistent),

- Ideen finden,

- Konzepte und Pläne erarbeiten.

Wer es besser kann: Die Konkurrenz

Jetzt müssen wir aus den tollen neuen Ankündigungen von OpenAI-Chef Sam Altman auch mal wieder die Luft rauslassen. Die kleinen Schwestern von ChatGPT zum Herunterladen erregen Aufmerksamkeit, weil OpenAI Marktführer ist, und weil sie vermutlich wirklich ganz gut arbeiten (gründlich konnte ich sie auch noch nicht testen).

Wie gesagt: so richtig auf Herz und Nieren testen konnte ich die kleinen ChatGPT-Geschwister noch nicht. Wie gut gpt-oss wirklich dasteht, wird uns in ein paar Wochen vielleicht das 🌐 LMArena-Leaderboard verraten – eine Website, auf der Userinnen und User die KI-Chatbots gegenander antreten lassen. Das ist, wie auch KI-Wissenschaftler sagen, vermutlich eine der ehrlichsten Methoden zu vergleichen, was eine KI wirklich taugt. (🌐 Science Media Center)

Fest steht: bei den KI-Modellen zum Herunterladen kommt OpenAI ziemlich spät auf eine Party, die schon ganz schön wild und belebt ist. Wer Ollama nutzt, muss nicht gpt-oss nutzen, sondern kann die KI-Modelle aus einem regelrechten Zoo aussuchen (🌐 Ollama-Modellüberblick). Welches KI-Modell man nutzt, ist dann eine Frage der persönlichen Vorliebe – und der Aufgaben, für die man es braucht.

Ich mag zum beispiel das aus Europa stammende Magistral, und ich bin sehr gespannt, ob gpt-oss:20b wirklich besser ist. Meine Vermutung: ist es nicht. Für Code-Bastler wie mich sind Alternativen ohnehin ein Muss: Zum Beispiel Qwen3-Coder, die neue Programmier-KI aus China. Oder wenn’s schnell gehen muss: Das winzige und schnelle Gemma3n von Google. „Reasoning“-Modelle wie gpt-oss sind prinzipbedingt langsamer und deshalb auch nicht immer die beste Wahl (mehr über Reasoning in diesem 🌐 Linkedin-KI-Newsletter-Häppchen).

…und wirklich offen ist GPT-OSS auch nicht

Und, Nerdmäkelei zum Schluss: Das OpenAI-Modell ist zwar „open-weights“ – das heißt: man kann das Modell herunterladen und unter der vergleichsweise entspannten Apache-2.0-Lizenz nutzen – aber es ist nicht wirklich „open-source“, das heißt: OpenAI verrät uns immer noch nicht, wie die KI eigentlich gebaut wurde.

Die chinesische Konkurrenz von DeepSeep ist da wesentlich offenherziger – war ja hier ausführlich Thema – und im Herbst kommt eine wirklich quelloffene europäische Alternative heraus, die Open-Source-KI der Forscherinnen und Forscher von der ETH Zürich, die auch sehr vielversprechend aussieht (🌐 ETH-Pressemitteilung). Auch die wird man dann in Ollama auf dem eigenen Rechner ausprobieren können.

Auch lesenswert:

- Quickie: So schreibt die KI deinen Programmcode mit!

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Agenten basteln: Lass die KI mit n8n für dich arbeiten!

Schreibe einen Kommentar