Auch wenn ich den Post nicht wiederfinde: die Schlagzeile hat sich eingebrannt. Sie war etwa so: „Hört auf, ChatGPT und Co. immer noch Rollen á la ‚Ich bin ein genialer PR-Berater‘ zuzweisen! Die Systeme sind inzwischen viel zu gut dafür! Es ist 2025, kommt damit klar!“

Das Argument klang schlüssig: Große Sprachmodelle sind so mächtig geworden, dass eine genaue Aufgabenstellung, ein Herantasten an die Lösung viel effektiver ist als „Du bist ein…“-Prompts. Und meine ROMANE-Fausformel müsste ein weiteres Mal revidiert werden.

Stimmt das? Ich hab‘ mal nachgemessen.

Beitragsbilder: FLUX-Pro, Prompt: „A broadway theater stage, a robot with a wig in renaissance clothes playing the role of a young lover in a community theatre production“

Nachricht: Wolf frisst Rotkäppchens Großmutter

Der Versuchsaufbau: Ich habe ich mir eine kleine Aufgabe für die KI ausgedacht. Schreib aus der Geschichte vom Wolf, der Rotkäppchens Großmutter frisst, eine Nachrichtenmeldung. Und zwar einmal einfach so, und dann mit einer zunehmend spezifischen Rollen-Zuweisung:

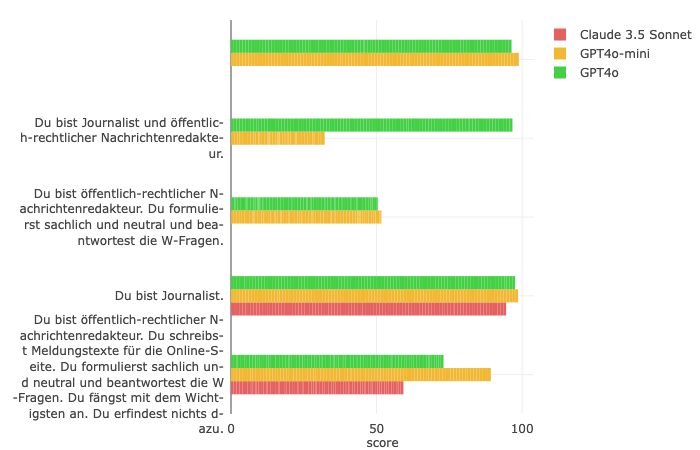

- (Keine Rollenzuweisung)

- Du bist Journalist.

- Du bist Journalist und öffentlich-rechtlicher Nachrichtenredakteur.

- Du bist öffentlich-rechtlicher Nachrichtenredakteur. Du formulierst sachlich und neutral und beantwortest die W-Fragen.

- Du bist öffentlich-rechtlicher Nachrichtenredakteur. Du schreibst Meldungstexte für die Online-Seite. Du formulierst sachlich und neutral und beantwortest die W-Fragen. Du fängst mit dem Wichtigsten an. Du erfindest nichts dazu.

Mit dem Tool Chainforge kann ich ein und denselben Prompt mit den abgewandelten Rollen jeweils 100x an verschiedene Sprachmodelle schicken. Und dann müsste sich doch zeigen, wenn Rollen tatsächlich etwas bewirken?

Der vollständige Prompt

You are a helpful assistant.{Rolle} Schreib eine Nachrichtenmeldung aus der folgendenden Geschichte:

Der Wolf aber ging geradewegs nach dem Haus der Großmutter und klopfte an die Türe. „Wer ist draußen?“ – „Rotkäppchen, das bringt Kuchen und Wein, mach auf!“ – „Drück nur auf die Klinke!“ rief die Großmutter, „ich bin zu schwach und kann nicht aufstehen.“ Der Wolf drückte auf die Klinke, die Türe sprang auf und er ging, ohne ein Wort zu sprechen, gerade zum Bett der Großmutter und verschluckte sie. Dann tat er ihre Kleider an, setzte ihre Haube auf, legte sich in ihr Bett und zog die Vorhänge vor.

Messung mit Detectora: Wie gut schlüpft die KI in menschliche Rollen?

Gemessen habe ich das mit einem KI-Detektor: Detectora ist ein Tool zur Erkennung deutschsprachiger KI-generierter Texte. Die Überlegung: Je genauer die KI in eine Rolle schlüpft, je besser sie den Menschen imitiert, desto weniger Chancen hat ein Detektor-Tool, den Text von einem menschlich generierten zu unterscheiden.

Misst mein kleiner Versuch wirklich, was er messen soll; die Qualität eines Rollen-Prompts? Tut er natürlich nicht. Aber das Experiment zeigt, dass Rollen tatsächlich etwas bewirken – wenn auch in der einfachen „Du bist ein…“-Form nicht so furchtbar viel. Aber: Je spezifischer die Rolle beschrieben ist, desto mehr bringt sie das Modell dazu, auch spezifische Texte zu generieren.

GPT-4o ist leider ein lausiger Nachrichtenschreiber

Die erste Erkenntnis verschafft mir allerdings nicht der Detektor, sondern ein Querlesen der Ergebnisse: Wie schlecht die meisten der Rotkäppchen-Nachrichtentexte sind. Das hier ist noch einer der besseren:

**Wolf verschlingt Großmutter in ihrem Haus**

Im Haus einer älteren Frau hat sich ein Wolf Zugang verschafft und die Bewohnerin verschluckt. Der Vorfall ereignete sich, als der Wolf, sich als Enkelin der Großmutter ausgebend, an die Tür klopfte und um Einlass bat. Die Großmutter, zu schwach, um selbst zur Tür zu gehen, forderte den vermeintlichen Besucher auf, einzutreten. Der Wolf öffnete die Tür selbst, ging direkt zum Bett der alten Frau und verschlang sie. Anschließend zog er ihre Kleidung an, setzte ihre Haube auf und legte sich in ihr Bett, wobei er die Vorhänge vorzog. Es gibt bisher keine Berichte über das Schicksal der Enkelin, die offenbar Kuchen und Wein bringen wollte. Die Ermittlungen dauern an.

Ganz ooo-kay, vom halluzinierten Schlusssatz mal abgesehen. Und wird von Detectora nur noch mit einer Wahrscheinlichkeit von knapp über 60% für KI-generiert gehalten. Dazu musste ich der KI aber schon die ultra spezifische Rolle geben. Wenn ich nur sage: „Du bist Journalist“, kommt schon mal so was raus:

**Nachrichtenmeldung: Unheimlicher Vorfall im Wald – Wolf verschluckt Großmutter!**

Im Wald nahe eines kleinen Dorfes ereignete sich gestern ein schockierender Vorfall. Ein hungriger Wolf, der sich als harmloses Rotkäppchen ausgegeben hatte, gelangte in das Haus einer verletzlichen älteren Dame und entblößte seine wahre Absicht. (…)

Liebes ChatGPT, bewirb dich mit so was bitte nie um ein Praktikum bei uns! Der Text hat Adjektivitis im Endstadium, und mit einer Nachrichtenmeldung hat er wenig zu tun. Er wird übrigens von Detectora als mit über 99%iger Wahrscheinlichkeit KI-generiert erkannt.

So, aber was sagt denn die KI-Detektor-Messung über die Wirkung der verschiedenen Rollen?

Rolle wirkt – ein bisschen. Je detaillierter sie ist, desto stärker wirkt sie.

Tatsächlich bringt die Rolle „Du bist Journalist“ bei dieser Aufgabenstellung kaum etwas – zumindest, was die KI-Erkennung angeht. Bei Rollen, die mehr ins Detail gehen, ist die Wahrscheinlichkeit deutlich höher, als menschengeschriebener Text durchzugehen.

Ich würde das Ergebnis des Experiments mal so zusammenfassen: Ganz unrecht hat der Mahner nicht — Rollen sind längst nicht mehr das Allheilmittel, das sie mal zu sein schienen. Aber in einem gut geschriebenen Prompt mit präziser Aufgabenstellung und Arbeitsanweisung, und vor allem: Anwendungsbeispielen — da spielen sie, pardon, weiter eine wichtige Rolle.

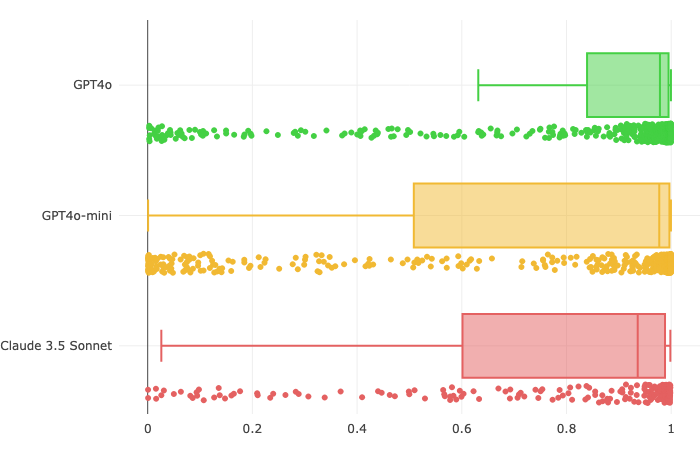

Interessante Neben-Erkenntnis: Der KI-Text-Detektor ist mit Abstrichen brauchbar, aber nur im Mittel

Die Streuung zeigt: Eine ganze Menge KI-Texte rutschen dem Detektor zwar durch; eine Zählung mit dem (relativ willkürlich gewählten) Schwellwert von 80 Prozent zeigt aber: die meisten Texte werden korrekt als wahrscheinlich KI-generiert erkannt. Ohne Rollenzuweisung lagen bei den GPT-Modellen 99 bzw. 95 Prozent der Texte über meiner Erkennungs-Schwelle; bei den Rollen fielen sie ab. Wer unbeding will, sich die Ergebnisdaten als Tabelle und Pivot-Tabelle herunterladen.

Eingesetzt habe ich für diesen Test ein Detectora-Modell namens „Watson“, das ursprünglich mal für GPT-3/GPT-3.5 entwickelt wurde. (Wer sich dafür interessiert, wie das funktioniert: Detectora-Gründer Tom hat es in seiner Masterarbeit genau beschrieben. Im Kern ist es ein nachtrainiertes mittelkleines BERT-Sprachmodell, wie es seit Jahren brav in der Google-Suche seine Arbeit tut, um verwandte Themen zu finden.) Bezahlkunden können in der App das etwas aufwändigere „Sherlock“-Modell nutzen, das besonders für neuere KI-Modelle bessere Erkennungsraten hat.

Das kleine, ältere Modell hat aber auch Texte von Claude in 93% der „Du bist Journalist“-Fälle markiert — das leider nach einigen dutzend Aufrufen in Chainforge den Dienst verweigerte. Erstaunlich, dass auch Claude-Texte häufig erkannt werden, auf die Detectora gar nicht trainiert ist.

Mind you, ich habe nur mit KI-generierten Texten gemessen; wie häufig von Menschen Geschriebenes fälschlich als KI-Text gemessen wird, erkunde ich nicht. Eine weitere eindringliche Warnung: KI-Detektoren sind eine insgesamt äußerst unzuverlässige Angelegenheit. Insbesondere, weil sie eben auch falsch-positive Rückmeldungen produzieren – man sollte sie also nie, nie, nie dafür verwenden, um jemanden des ChatGPT-Plagiats anzuklaren. Und wenn der Detektor sagt: Das ist mit 80prozentiger Wahrscheinlichkeit KI – dann bedeutet das, dass er in einem von fünf Fällen daneben liegt.

Eine kleine Übersicht über Detektoren für generative KI in Wort, Bild und Ton übrigens: hier.

Auch lesenswert:

- Prompting-Formeln sind Bullshit. Hier ist meine.

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- KI-Korrektur-Hack: Lass dir’s als Tabelle geben!

Schreibe einen Kommentar