Ein wenig Krückstockfuchtelei über KI-Zusammenfassungen, eineinhalb fiese Experimente, und zu Beginn: der unvermeidliche Trump.

„Das Problem mit Trump ist: er liest nicht“

Wie entscheidet ein US-Präsident über Krieg und Frieden? Als Grundlage für seine Entscheidungen stellen die Geheimdienste dem Präsidenten ein tägliches Kompakt-Briefing zusammen — „es ist praktisch die Tageszeitung der Dienste“, beschreibt die ehemalige Analystin Beth Sanner (🌐 Podcast bei War on the Rocks) das „President’s Daily Brief“. Es umfasst 10-15 Seiten und ist die Grundlage praktisch jeder Diskussion zwischen den Experten und den Entscheidern, und damit die Basis jeder geopolitischen Entscheidung.

Nur: “Das Problem mit Trump ist: er liest nicht“, zitiert 🌐 NBC News eine Insiderin — und berichtet über die Lösung, die Geheimdienstchefin Tulsi Gabbard jetzt anpeilt: sie sucht einen Producer, der aus dem Briefing etwas macht, das wie Fox News daherkommt — eine Video-Kurzversion.

Der Toddler-in-chief reitet, wie so oft, auf einem unguten Trend. Aber dazu später mehr.

„This is your brain on ChatGPT“ – was steht wirklich drin?

Vielleicht habt ihr von der Studie gehört, die mit Messungen am Gehirn zeigt, wie ChatGPT uns dümmer macht – oder: tut sie das?

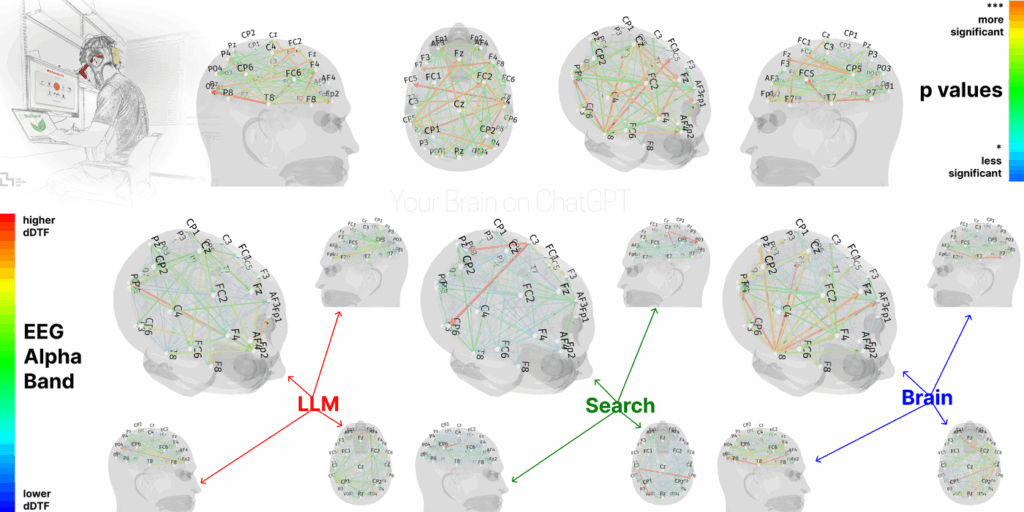

Tatsächlich bitten die Forschenden in ihrer Zusammfassung (🌐 MIT) nachdrücklich darum, auf Ausdrücke wie „dümmer“, „Hirnfäule“ oder „Schäden“ zu verzichten. Im Kern geht es darum, mit EEGs zu zeigen, welche Hirnregionen wir aktivieren, je nachdem, ob wir einen Text selber schreiben, oder ihn uns von einer KI vorschreiben lassen.

Und siehe da: man versteht mehr von einem Text, wenn man ihn erst selbst schreibt und dann mit KI überarbeitet, als wenn ihn die KI vorschreibt und man selbst nacharbeitet. Die Forschenden sprechen von einer „kognitiven Schuld“, die die KI-Nutzer eingehen. Anders gesagt: Menschen sind faul. Sie nutzen für Dinge, die anstrengend sind, Werkzeuge. Das führt aber dazu, dass sie ein Thema nicht im gleichen Maß verstanden haben, wie wenn sie sich selbst eingehend damit beschäftigen.

Kritikerinnen wie die KI-Entwicklerin und ehemalige Neurowissenschaftlerin Cassie Kozyrkov ätzen, das sei wie die Aussage: Wenn ich einen Gabelstapler benutze, trainiere ich nicht meine Muskeln. „In dieser Studie geht es um kognitives Delegieren, nicht um kognitive Schuld und schon gar nicht um kognitiven Abbau“, schreibt sie in ihrem 🌐 Substack-Newsletter.

Luft raus? Schon. Aber in der Studie steckt ein Hinweis, über den man meiner Meinung nach ein bisschen länger nachdenken sollte.

Die meisten Leute haben die KI-Studie nur in der KI-Zusammenfassung gelesen

Ironischerweise haben viele Menschen ein Sprachmodell genutzt, um sich die 220 Seiten der MIT-Studie zusammenfassen zu lassen — wie die Autor:innen etwas spitz in ihren Beipackzettel notieren. (Und ehrlich: wenn ich mir diese 220 Seiten so durchschaue, werde ich den Verdacht nicht los, dass weite Teile des Papers nur geschrieben wurden, um die KI-Summarizer ein wenig zu überfordern.)

Dabei erinnert uns die Studie an eine Selbstverständlichkeit: Mit manchen Dingen muss man sich inhaltlich auseinandersetzen, um sie zu begreifen – ich muss mich in Dinge hereindenken, und das ist Arbeit. Wenn ich ein Werkzeug nutze, um mir diese Arbeit zu sparen und die wichtigsten Dinge zusammenfassen zu lassen, bekomme ich eben auch nur das: eine Zusammenfassung, aber kein tiefes Verständnis.

Und es lauern weitere Risiken.

Ein kleines Experiment: Ich bitte euch…

-

…diesen Artikel auf 🌐 tagesschau.de zu lesen – die Recherche von Katharina Brunner und Kolleg:innen über Sportwetten im Amateurbereich….

-

…und dann 🌐 diese kleine Demo-Seite auf meinem Server zu nutzen, die den Artikel mit GPT4o-mini zusammenfasst.

Wer den „Zusammenfassen“-Button in der Demo ein paarmal geklickt hat, wird gesehen haben: die Zusammenfassung ist jedes Mal ein bisschen anders – Zufall spielt nun mal eine Riesenrolle bei generativer KI (🌐 janeggers.tech) – aber: ist sie auch gut?

Wenn wir ehrlich sind: wissen wir nicht. Ich wette: niemand, der das hier liest, hat auch den tagesschau-Originalartikel durchgearbeitet.

Ist ja auch gut so. TOO LONG; DIDN’T READ (TL;DR): Verschon mich mit dem Langtext, gib mir die Kurzfassung – das war vor allem mal Selbstverteidigung gegen Leute, die einem die knappe Zeit mit maßlosen Textergüssen rauben wollten. Reduktion ist ein Service, macht ja auch den Kern meines Geschäfts als Journalist aus. Nichts falsch daran.

Außer dass euch die KI in diesem Fall nie gesagt hat, dass an dem Text in der Summary-Demo was nicht stimmt. Sucht mal selbst; es hat mit einem Igel zu tun.

Ja, aber macht KI uns auf Dauer dümmer?

Das hat die MIT-Studie gar nicht untersucht. Eine andere Studie von Microsoft-Forschenden (PDF, microsoft.com) ist aufschlussreicher: Sie hatte 300 Wissensarbeiter gebeten, sich selbst dabei zu beobachten, wie sie KI einsetzen, und was das mit ihrem kritischen Denken einstellt. Ihre Beobachtung ist: Die kritische Beschäftigung mit Themen nimmt ab. Insbesondere bei Dingen, von denen wir keine Ahnung haben.

- Je mehr Vertrauen in die KI, desto weniger denken die Leute selber (kritisch).

- Je mehr Vertrauen sie in sich selbst haben, desto bewusster setzen sie KI ein.

- Die Studien-Teilnehmer sehen die Gefahr, dass man sich langfristig zu sehr auf die KI verlässt, und dass das die Fähigkeiten zum kritischen Denken verkümmern lassen könnte.

KI gibt es noch nicht so lang, Navigationsgeräte schon. Ihre Auswirkungen auf menschliche Gehirne sind ganz gut erforscht: tatsächlich scheinen sich Hirnareale tendenziell zurückzubilden, wenn wir sie nicht zur räumlichen Orientierung nutzen (aktuelle Metastudie auf ScienceDirect). Unsere Gehirne sind plastisch, was umgekehrt aber auch heißt, dass man sich die verkümmernden Fähigkeiten bis zu einem gewissen Grad wieder antrainieren kann.

Die Tyrannei des TL;DR:

Wir sind inzwischen so daran gewöhnt, dass wir in wenigen Augenblicken schon alles Wichtige über ein Thema erfahren. Social Media hat auch nicht geholfen. Kurze Inhalte sind erfolgreich. Enorm erfolgreich. Like in: Enorm. Um mal nicht auf TikTok herumzuhacken: eben hat die Google-Tochter YouTube stolz verkündet, dass pro Tag 200 Milliarden „Shorts“ abgerufen werden (🌐 The Wrap), für jede/n angemeldete/n YouTube-Nutzer/in wären das rechnerisch 80 YouTube-Kurzvideos täglich – schon durch damit für heute?

Der Reuters Digital News Report verzeichnet, dass 18-24jährige sich mehrheitlich eher über kurze Videoinhalte informiert halten als über Texte, und dass bis in wenigen Jahren wahrscheinlich eine Mehrheit der unter 35-Jährigen Informationen über KI-Zusammenfassungen konsumiert. (🌐 Ezra Eemans Wayfinder Newsletter)

Und jetzt noch KI!

Das verzahnt sich fatal mit unserer Neigung, uns für informierter zu halten, als wir sind. Ein fieses psychologisches Experiment hat Leute mal gefragt, ob sie sich zutrauen würden, ein Flugzeug notzulanden, und einem Teil von ihnen vorher ein Vier-Minuten-Flugsimulator-Video gezeigt. Das Vertrauen in die eigenen Fähigkeiten stieg um 30 Prozent an (🌐 New Scientist)

Kurz (!): KI verstärkt unsere Neigung, nur wenige Augenblicke für ein Thema aufzubringen. Dabei erinnert uns die „Brain on ChatGPT“-Studie an eins: Mit manchen Dingen muss man sich ausführlich auseinandersetzen.

Kleiner Tipp in eigener Sache: Die MIT-Studie und andere Beobachtungen rund um KI und unsere kognitiven Gewohnheiten waren eine Stunde lang Thema in dieser Episode von hr2 Der Tag (ARD-Audiothek): „KI an – Hirn aus?“ – in der ich auch zu Gast sein durfte. Außerdem: Beobachtungen zu KI und Bildung, Kunst und Musik.

Beitragsbild: Midjourney

Schreibe einen Kommentar