Ein und dieselbe Person in mehreren Bildern – oder ein und derselbe Stil: Das war bislang eine der schwierigsten Aufgaben mit KI-Bildgeneratoren. Neue Modelle wie „Nano Banana“ erleichtern das enorm – und sind doch nicht die Lösung für alles. Eine dreiteilige Miniserie – mit ein paar miesen, aber funktionalen Tricks.

- Teil 1: Dieselbe Person, eine andere Waffe?

Mannomann, am liebsten hätte ich das Seminar abgesagt! Ein Seminar über KI-Bildgeneratoren – das ich das letzte Mal im Mai gehalten hatte. Und ich fragte mich, ob ich nicht das ganze veraltete Seminar über den Haufen werfen muss.

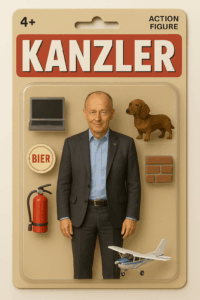

Denn seit damals™️ ist eine Menge passiert: Im Mai 2025 schaltete OpenAI den neuen ChatGPT-Bildgenerator frei – mit dem wir uns alle in Ghibli-Charaktere oder Actionfiguren verwandeln lassen konnten. Und Ende August kam dann Googles „Gemini 2.5 Image“, besser bekannt als „Nano Banana“ – und ich fragte mich: wenn das ohnehin jeder nutzen kann – auf aistudio.google.com haut Google ordentlich Frei-Credits für die neue Wundertechnik raus – was soll ich den Leuten noch über Diffusion-Modelle erzählen, über Stilprompts, Finetuning und andere magische Zutaten? Alles nicht mehr nötig?

Am Ende war ich dann sehr froh, dass wir das Seminar doch gemacht haben. Ich habe viel gelernt. Zum einen habe ich gehört, dass ein Drittel der Seminarteilnehmer Nano Banana schon regelmäßig nutzt – das zeigt, wie schnell sich Nano Banana durchsetzt; selbst wenn man berücksichtigt, dass die Stichprobe nicht repräsentativ ist. Zum anderen habe ich den JSON-Trick gelernt. Aber der Reihe nach.

Unser Ziel: Die oft sehr eigenwilligen Bildgeneratoren zivilisieren.

Erster Schritt: Dieselbe Person in allen Bildern

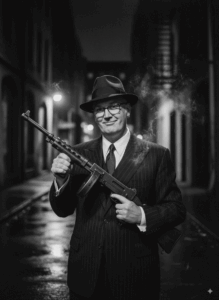

Aufgabenstellung: Ich möchte ein Bild von mir als Gangster.

Tun wir für einen Moment so, als gäbe es die Hybridmodelle nicht; als hätten wir keine Möglichkeit, Bilder von uns selbst als Vorbild hochzuladen. So war die Situation ja noch vor einem halben Jahr. Dann habe ich für diese Aufgabe zwei Möglichkeiten:

- Ich nutze ein Foto von mir als Bild-Prompt – am besten mit Midjourney.

- Ich trainiere ein KI-Modell nach – am besten ein offenes, frei herunterladbares Modell wie Flux.

Ein KI-Modell selber nachzutrainieren klingt ziemlich nerdy, ist aber auch schnell erledigt. Man nehme:

- das frei herunterladbare FLUX-Dev

- 10-20 Bilder von sich selbst

- einen Service wie 🌐 Replicate, der das Trainieren und das Hosting des angepassten Modells um nicht teuer Geld anbietet.

Die Bilder packe ich in eine ZIP-Datei – die Streber machen vorher noch Bildbeschreibungen und packen sie entweder in den Dateinamen oder gleich benannte Textdateien; man kann aber auch die KI die Bilder beschreiben lassen – lade die hoch, vereinbare ein Zauberwort für die hochgeladene Person, und klicke auf „Trainieren“. Das Ergebnis kostet mich eine halbe Stunde und zwei, drei Dollar, dann kann ich das angepasste Modell über eine API oder notfalls über die Replicate-Seite nutzen.

Über die unterschiedlichen Möglichkeiten, ein Bild in Midjourney als Referenz zu nutzen, habe ich schon mal geschrieben; seitdem hat Midjourney die „Character Reference“ durch den --omni Prompt ersetzt, der für unsere Zwecke perfekt geeignet ist: Er transportiert die dargestellte Person in das generierte Bild.

Bewertung: Selbst Modelle mit dem eigenen Bild zu trainieren ist als Gag vertretbar, aber eigentlich nicht mehr nötig – dafür ist die Konkurrenz zu gut geworden. Die Methode ist unflexibel und teuer. Eine Bildreferenz in Midjourney ist praktikabel, liefert aber oft nicht die erwarteten Ergebnisse; da ist eine Menge Rumprobieren gefragt.

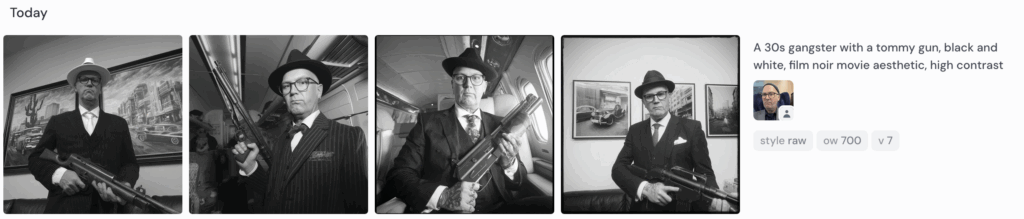

Und ja: All diese Dinge bekommt man auch gut mit „Nano Banana“ hin. Sort of. Prompt war: „Make me a picture of me: A 30s gangster with a tommy gun, black and white, film noir movie aesthetic, high contrast. 1:1 aspect ratio.“ Beim ersten Versuch griff – zum allerersten Mal – ein Contentfilter zu. Vielleicht hat ihn das „me“ ausgetrickst, wahrscheinlich war’s einfach wieder nur Zufall; mein Eindruck ist jedenfalls, dass auch Google das Ausfiltern von Bildern, die für persönliche Angriffe genutzt werden können, nicht mehr sonderlich ernst nimmt.

Und ja: All diese Dinge bekommt man auch gut mit „Nano Banana“ hin. Sort of. Prompt war: „Make me a picture of me: A 30s gangster with a tommy gun, black and white, film noir movie aesthetic, high contrast. 1:1 aspect ratio.“ Beim ersten Versuch griff – zum allerersten Mal – ein Contentfilter zu. Vielleicht hat ihn das „me“ ausgetrickst, wahrscheinlich war’s einfach wieder nur Zufall; mein Eindruck ist jedenfalls, dass auch Google das Ausfiltern von Bildern, die für persönliche Angriffe genutzt werden können, nicht mehr sonderlich ernst nimmt.

Kleiner Einschub: Persönlichkeitsrechte unter Beschuss

Erinnerung an Presserecht für Anfänger: Dass jemand ein Bild von mir veröffentlicht, besonders ein manipuliertes, muss ich nicht hinnehmen. Schon gar nicht, wenn das Bild mich in einer Situation darstellt, die es so nicht gab. Trotzdem lässt sich damit natürlich ein prima Geschäftsmodell machen: „Nudifier“-Apps (🌐 indicator.media), hinter dem sich noch ganz andere finstere Interessen verstecken können: Russische Hackergruppen spielen anscheinend auch im Auszieh-Business mit. (🌐 404 Media)

Technisch sind das vermutlich keine Bildgeneratoren, sondern Deepfake-Varianten, bei denen ein Autoencoder die Gesichtszüge und Körpermaße des Vorbilds auf die neuen Bilder überträgt. Eine harmlosere Variante der spezial-nachtrainierten Modelle sind KI-Services, die mir erlauben, ein Kleidungsstück an einem Model in eine Landschaft zu stellen, wenn ich mir keine teuren Model-Shoots leisten kann oder will.

Dasselbe Bild, andere Elemente

Von Flux gibt es seit Mai eine Variante namens Flux Kontext Pro, die mir erlaubt, ein Bild als Ausgangsmaterial vorzugeben – und dann über einen Prompt zu verändern:

Wenn ihr’s nicht weitersagt, liebe Leser:innen: hier könnt ihr Flux Kontext Pro ausprobieren – über Replicate in eine App auf meinem Server eingebunden. Aber macht mich nicht arm.

Beeindruckend, allerdings zur gleichen Zeit von der großen Konkurrenz ziemlich heftig abgegrätscht.

- Teil 2: Der Große Sprung vorwärts! Hybrid-Modelle für die volle Bildkontrolle

- Teil 3: Bewahr dir meinen Stil! Wie man ein KI-Bild mit einer Handschrift versieht

Auch lesenswert:

- Besser prompten: Gib der KI gut strukturierte ROMANE!

- Stilübung (2): Hybrid-Modelle für die volle Bildkontrolle

- Prompting-Formeln sind Bullshit. Hier ist meine.

Schreibe einen Kommentar